1.WANN:学習せずとも特定タスクを実行できるニューラルネットワークの探索(3/3)まとめ

・トレーニングしなくても画像情報からカーレースゲームをプレイするシンプルなWANNは発見済み

・ランダムな重みを使う事で同一モデルでアンサンブル学習を行いMNISTの精度を向上できた

・WANNはエージェントが生涯を通じてスキルを習得する生涯学習の継続に役立つ可能性がある

2.WANNの性能

以下、ai.googleblog.comより「Exploring Weight Agnostic Neural Networks」の意訳です。元記事は2019年8月27日、Adam GaierさんとDavid Haさんによる投稿です。

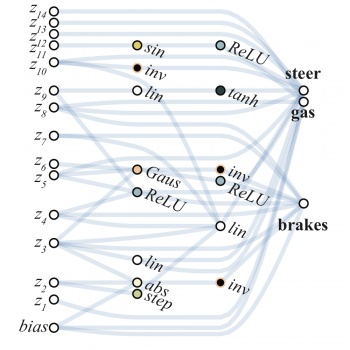

パフォーマンスとネットワークのシンプルさの両方を目的とした多目的最適化の使用により、ネットワークの重みを明示的にトレーニングしなくてもうまく機能する画像情報からカーレースゲームをプレイするシンプルなWANNを発見しました。

ランダムな重みのみを使用しても機能するネットワークアーキテクチャには、他の利点もあります。

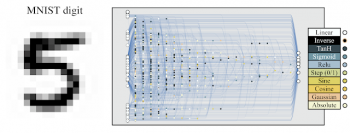

たとえば、同じWANNアーキテクチャのコピーを使用し、WANNの各コピーに異なる個別の重み値が割り当てれば、同じタスクに対して複数の個別のモデルとしてアンサンブルを作成できます。このアンサンブルは通常、単一のモデルよりも優れたパフォーマンスを実現します。これを、ランダムな重みで動作するように進化したMNIST分類器の例を使用して以下で説明します。

MNIST分類器は、ランダムな重みで機能するように進化しました

従来のネットワークでランダムに初期化した重みを使用するとMNISTで10%以下の精度になりますが、WANNのネットワークアーキテクチャにランダムな重みを使用し、MNISTに適用すると、偶然よりもはるかに高い精度、(80%超)を達成します。WANNをアンサンブルで使用すると、それぞれに異なる共有ウェイトが割り当てられ、精度は90%超を達成します。

アンサンブルがなくても、ネットワーク内の重み値の数を1つにまとめれば、ネットワークを迅速に調整できます。重みをすばやく微調整する能力は、エージェントが生涯を通じてスキルを習得、適応、および転移する生涯学習を継続するのに役立つ場合があります。

これにより、WANNは、「学習を学ぶ」という計算コストの高いトラップにとらわれることなく、有用な行動を習得する素質に報いる進化的圧力であるボールドウィン効果(訳注:生存に有利な特定の振る舞いを学習する能力が世代を経るにつれて種族内で向上する効果)を活用するのに特に適した位置にあります。

まとめ

この研究が、畳み込みネットワークのような、その発見と応用が深層学習の驚くべき進歩に役立つ新しい基本的なニューラルネットワークコンポーネントを発見するための足がかりになることを願っています。

時間畳み込みニューラルネットワークが発見されて以来、研究コミュニティが利用できる計算機リソースは大幅に増加しています。このリソースを自動検出に専念し、ネットワークアーキテクチャの漸進的な改善以上を達成したいと考えている場合は、コンポーネントの配置だけでなく、新たな土台となるコンポーネントを検索する価値があると考えています。

この研究について更に詳しく知りたい場合は、インタラクティブなWebページ(またはオフラインで読む場合はPDF版の論文)を読む事に読者を招待します。これらの実験を研究コミュニティに公開することに加えて、Neatの一般的なPython実装であるPrettyNEATをリリースし、興味のある読者がニューラルネットワークの進化のエキサイティングな領域を第一原理から探求できるようにします。

3.WANN:学習せずとも特定タスクを実行できるニューラルネットワークの探索(3/3)まとめ

1)ai.googleblog.com

Exploring Weight Agnostic Neural Networks

2)weightagnostic.github.io

Weight Agnostic Neural Networks

3)github.com

google/brain-tokyo-workshop

rain-tokyo-workshop/WANNRelease/prettyNEAT/

4)twitter.com

@hardmaru

コメント