1.WANN:学習せずとも特定タスクを実行できるニューラルネットワークの探索(2/3)まとめ

・WANNは新しいアーキテクチャ探索中に個々の重みを学習させる必要がない

・ネットワークのパフォーマンスと複雑さの両方を同時に最適化する事も可能

・パフォーマンスは接続ごとにウェイトを学習する一般的なニューラルネットワークには匹敵しない

2.WANNのトレーニング

以下、ai.googleblog.comより「Exploring Weight Agnostic Neural Networks」の意訳です。元記事は2019年8月27日、Adam GaierさんとDavid Haさんによる投稿です。

WANNを見つける

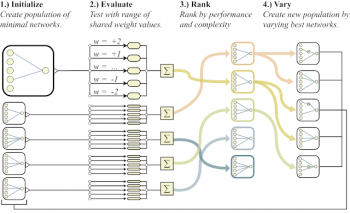

非常に少ない接続のみを備えた最小限のニューラルネットワークアーキテクチャ候補を母集団として、確立されたトポロジ検索アルゴリズム(NEAT:NeuroEvolution of Augmenting Topologies)を使用して、単一の接続と単一のノードを1つずつ追加してアーキテクチャを進化させます。

WANNの背後にある重要なアイデアは、重みを重視せずにアーキテクチャを検索することです。新しいアーキテクチャの全ての重みパラメータを学習アルゴリズムを使用してトレーニングして性能を確認する必要がある従来のニューラルアーキテクチャ探索方法とは異なり、よりシンプルで効率的なアプローチを採用しています。

ここでは、探索中、各反復で全ての候補アーキテクチャに最初に単一の共有重み値が割り当てられ、次に幅広く共有された重み値で適切に実行されるように最適化されます。

ネットワークトポロジのスペースを探索するための手順

左:入力と出力が部分的にしか接続されていない最小限のネットワークトポロジ

中間:ネットワークは、次の3つの方法のいずれかで変更されます。

(1)ノードの挿入:既存の接続を分割することにより、新しいノードが挿入されます。

(2)接続の追加:以前は接続されていなかった2つのノードを接続することにより、新しい接続が追加されます。

(3)アクティベーションの変更:隠れ層のノードのアクティベーション関数が入れ替えられます。

右:可能な活性化関数の例(線形、ステップ、サイン、コサイン、ガウジアン、ハイパボリックタンジェント、シグモイド、逆数、絶対値、ReLU)

様々な重みに依存しないニューラルネットワークの探索に加えて、必要なだけ複雑なネットワークアーキテクチャを探すことも重要です。これは、多目的最適化を参考にした手法を使用して、ネットワークのパフォーマンスと複雑さの両方を同時に最適化することでこれを達成します。

重みに依存しないニューラルネットワーク探索の概要と、ネットワークトポロジのスペースを探索するための対応する手順

WANNアーキテクチャのトレーニング

従来のネットワークとは異なり、WANNは、パフォーマンスを最大化する最適な単一共有ウェイトパラメーターを見つけるだけで簡単にトレーニングできます。

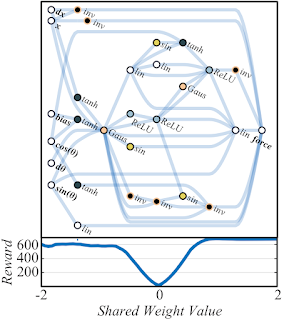

以下の例では、Cartpole Swing-upタスクに対して一定の重みを使用するアーキテクチャが(ある程度)機能している事がわかります。

WANNで様々な重みパラメーターでCartpole Swing-upタスクを実行した結果と、微調整した重みパラメーターを使用した結果。

上の図でわかるように、WANNは様々な共有ウェイトパラメーターを使用してタスクを実行できますが、パフォーマンスは個々の接続ごとにウェイトを学習する一般的なニューラルネットワークには匹敵しません。

パフォーマンスをさらに向上させたい場合は、WANNアーキテクチャを使用し、最適な共有ウェイトを開始点として、通常のニューラルネットワークのトレーニング方法のように、学習アルゴリズムを使用して各接続のウェイトを微調整できます。

このように、ネットワークアーキテクチャの重みに依存しないプロパティから開始し、学習を介してパフォーマンスを微調整することで、動物の学習方法に対する洞察が得られる場合があります。

3.WANN:学習せずとも特定タスクを実行できるニューラルネットワークの探索(2/3)まとめ

1)ai.googleblog.com

Exploring Weight Agnostic Neural Networks

2)weightagnostic.github.io

Weight Agnostic Neural Networks

3)github.com

google/brain-tokyo-workshop

rain-tokyo-workshop/WANNRelease/prettyNEAT/

4)twitter.com

@hardmaru

コメント