1.Off-Policy Classification:強化学習モデルを選別する新手法(1/2)まとめ

・完全ポリシー外強化学習は過去に収集されたデータのみを使って学習するタイプの強化学習

・物理的なロボットがなくてもモデルをトレーニングが出来るのでスケールアップが容易

・しかし、最終的なモデルの評価はロボットが必要でありそれがポリシー外分類の開発同期となった

2.off-policy強化学習とは?

以下、ai.googleblog.comより「Off-Policy Classification – A New Reinforcement Learning Model Selection Method」の意訳です。元記事は2019年6月19日、Alex Irpanさんによる投稿です。

強化学習(RL:Reinforcement learning)は、エージェントが経験から意思決定を学ぶことを可能にするフレームワークです。

強化学習には様々な種類がありますが、そのうちの一つはポリシー外強化学習(off-policy RL)です。

ポリシー外強化学習では、「ポリシー外データ(off-policy data)」、すなわち他のエージェントによって収集されたデータと、エージェント自身で収集したデータの組み合わせを使用してエージェントが訓練されます。これにより、ロボットに悪路を歩行させたり、落ちている物体を拾い上げさせるなど、様々な一般化可能なスキルを習得する事ができます。

対照的に、「完全ポリシー外強化学習(fully off-policy RL)」は、エージェントが過去に収集されたデータのみを使って学習するタイプの強化学習であり、物理的なロボットを必要とせず、モデルの反復学習を可能にするので魅力的です。

完全ポリシー外強化学習では、過去のエージェントによって収集された同一の固定データセットで複数のモデルを訓練してから、最良のモデルを選択する事ができます。

ただし、完全ポリシー外強化学習には問題があります。実際のロボットがなくてもトレーニングは可能ですが、モデルの評価(つまり本当にそのモデルが悪路を歩けるのか否かなど)ができないのです。

更に、物理的なロボットを使ってモデルの評価をする事は、AutoMLによる自動アーキテクチャ探索など、莫大な数のモデルの評価を必要とする有望なアプローチを採用するためには、多数のロボットが評価時に必要になるため非効率です。

この課題は、他のエージェントからのデータを使用して新規エージェントの品質を調査する手法である、ポリシー外評価(OPE:off-policy evaluation)の開発動機となります。

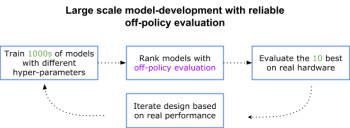

OPEによる順位付けを使えば、最も有望なモデルのみを選択的に実世界のロボットでテストでき、実ロボットに使える予算が固定であっても、テスト対象モデルを大幅に拡大できます。

実世界モデル開発の図。1日に10個のモデルをロボットを使って評価できると仮定すると、ポリシー外評価がなければ、全モデルを評価するためには100倍の日数が必要になります。

ポリシー外評価、つまりOPEフレームワークは有望ですが、過去データからパフォーマンスを正確にランク付けするポリシー外の評価方法が存在する事を仮定しています。

しかし、過去の経験を実際に収集したエージェントと、収集済情報から学習したエージェントは、全く異なる動作をする可能性があるため、適切なパフォーマンスを見積もる事は困難です。

論文、「Off-Policy Evaluation via Off-Policy Classification」では、ポリシー外分類(OPC:off-policy classification)と呼ばれる新しいポリシー外評価手法を提案しています。

ポリシー外分類では、ポリシーの評価を分類問題として扱うことによって、過去データから学習したエージェントのパフォーマンスを評価します。ここで、「アクション」とは「成功をもたらすアクション」、または「失敗をもたらすことが保証されるアクション」として分類されます。

私達の手法は、画像(カメラ)入力に対して適用が可能であり、「重要度サンプリングに基づいた再重みづけ」や「ターゲット環境の正確なモデルの構築」など、従来の研究で一般的に使用されていた2つのアプローチを必要としません。

私達はOPCが、カメラを用いたロボットによる物体拾い上げタスクを含む、現実世界での様々なタスクに広く拡張できる事を示しました。

OPCの動作原理

OPCは2つの仮定に依拠しています。

1)最終タスクは決定論的ダイナミクスを有する、すなわち、状態がどのように変化するかに無作為性は含まれない

2)各試行の終わりにエージェントの行動は成功または失敗する。

各試行は決定論的な方法で成功するか失敗するかのどちらかであるため、各アクションに0か1かのバイナリ分類ラベルを割り当てることができます。

私達は、成功につながる可能性がある場合はアクションを有効(effective)とし、失敗につながることが保証されている場合は破滅的(catastrophic)としています。

OPCは、エージェントが現在の状態から何らかの行動を取ることを選択した場合に将来の総報酬を推定する、Q学習アルゴリズムで学習したQ関数を利用します。次にエージェントは最大の合計報酬見積もりを持つアクションを選択します。

本論文では、エージェントのパフォーマンスは、「選択されたアクションが有効なアクションである頻度」によって測定されることを証明します。これは、Q関数がアクションを「有効な行動」または「破滅的な行動」として正しく分類できている程度に依存します。

そして、この分類精度は、ポリシー外評価のスコアとして機能します。

しかし、過去の試験データのラベル付けは部分的にすぎません。たとえば、前回の試行が失敗した場合、どのアクションが壊滅的なアクションだったのかわからないため、負のラベルは付けられません。

これを克服するために、半教師つき学習、特にPositive-Unlabeled Learning(PU learning:一部の成功事例だけに「成功」のラベルがついているデータから学習する手法。残りのラベルが付いていない事例は成功事例と失敗事例が混在しているため、従来の学習手法では分類させる事が難しい)を活用します。これにより、部分的にラベル付けされたデータから分類精度の推定値を得る事が可能になり、この精度がOPCスコアです。

3.Off-Policy Classification:強化学習モデルを選別する新手法(1/2)関連リンク

1)ai.googleblog.com

Off-Policy Classification – A New Reinforcement Learning Model Selection Method

2)arxiv.org

Off-Policy Evaluation via Off-Policy Classification

コメント