1.Conceptual Captions:自動収集された新しい画像データセットまとめ

・人工知能を使ってネット上のIMGタグのALT属性からキャプションと画像を収取する試みが発表

・Conceptual Captionsと名付けられたこの手法はスケーラビリティが高く応用範囲が広い

・従来のMS-COCOデータセットと比較しても質の高い学習に繋がる事が確かめられている

2.Conceptual Captions、概念的キャプションのデータセットとは?

以下、ai.googleblog.comより「Conceptual Captions: A New Dataset and Challenge for Image Captioning」の意訳です。

インターネットには何十億もの画像が溢れており、様々なテーマで世界中の人々を楽しませたり、情報や見聞を提供しています。しかし、画像のように視覚に頼る情報の多くは、視覚障害のある人や、インターネット回線の速度が遅い人にとってはアクセスが困難です。

Webページ作成者がHTMLのIMGタグのAlt属性を使い、画像にキャプション(画像が何を表現しているのか説明する部分章)を手動で追加する事は、そのページのアクセシビリティを向上させるための有用な手段です。TTS(テキスト読み上げシステム)はAltで指定されたキャプションを読み上げて画像が何を表現しているのかをユーザに伝える事ができます。

しかし、Altキャプションが付いている画像はインターネット全体でみるとあまり多くはありません。自動で画像キャプションを付与するソフトはこの問題を解決するのに役立ちますが、正確な画像キャプションはコンピュータビジョンと自然言語処理の両方の最新技術を更に進化させることを必要とする難題です。

画像のキャプションをテキストに変換することで、何百万人もの視覚障害を助けることができます。 CC BY 2.0ライセンスで使用されているFrancis Vallance氏(Heritage Warrior)の画像。この画像のキャプションは「山々に続く道」となる。

本日、私達はConceptual Captions(概念的なキャプション)を紹介します。Conceptual Captionsは、数十億のWebページから画像キャプションや注釈を自動的に抽出し、選別することによって作成された、約330万の画像とキャプションのペアで構成される新しいデータセットです。

ACL2018で発表された論文で紹介されたConceptual Captionsは、人間が手で作成したMS-COCOデータセットよりも規模が大きいキャプション付き画像データセットです。人間の評価者によって品質を測定した結果、機械的に収集されてキャプションが付けられたConceptual Captionsは約90%以上の正確があると測定されています。さらに、Conceptual Captionsの画像はインターネット全域から取り出されるため、従来のデータセットよりも幅広い種類の画像とキャプションを含みます。そのため、Conceptual Captionsを使って人工知能を学習させると学習の品質も高くする事が可能です。

画像キャプションの進展状況を追跡するために、私達は機械学習コミュニティに対してConcept Captions Challengeコンペも発表します。コンペ参加者が作成した画像キャプションモデルは実際のConceptual Captions環境に近い試験環境で訓練され、評価されます。

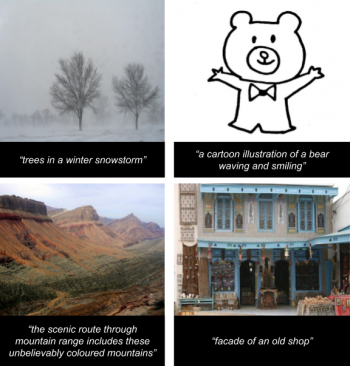

Concept Captionsデータセットの画像とキャプションの図。

左上から時計回りに、Jonny Hunter(吹雪の中の木々)、SigNote Cloud(笑顔で手を振っている熊の漫画チックなイラスト)、Tony Hisgett(信じられないほどの色鮮やかな山々の間を通る景色の良い道)ResoluteSupportMedia(古い店のファサード)による画像。 CC BY 2.0ライセンスで使用されているすべての画像

データセットの生成

Conceptual Captions のデータセットを生成するために、私達はWebからAlt属性を持つ画像を収集することから始めました。我々は自動的に特定のプロパティを取捨選択し、18禁テーマなどの望ましくないコンテンツを避けながら、品質を担保する必要がありました。その後、テキストベースのフィルタリングを適用して、説明的でないテキスト(ハッシュタグ、文法的に変な文章、またはイメージに関係しない言語など)を含むキャプションを削除します。また、感情的な文や成人向けの内容のテキストを破棄します(フィルタリング基準の詳細については、論文を参照してください)。

その後、既存の画像分類モデルを使用して、任意の画像に対して、そのAlt属性の単語(同義語等は許容します)と画像分類器がその画像を分類した結果に重複があることを確認します。

固有名詞から一般的な概念への変換

上記のフィルタを通過する候補文は、画像を上手に説明する優れたAltキャプションの傾向がありますが、多くの文では固有名詞(人、会場、場所、組織などで)を使用している傾向もあります。画像キャプションモデルに入力画像からそのように細かい固有名詞を推論させ、同時に自然言語を生成させることは非常に困難な問題です。

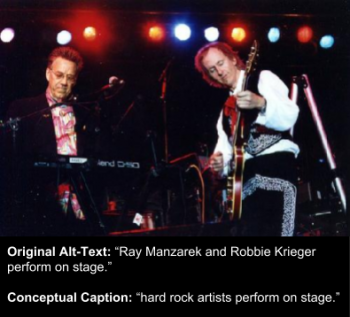

上記の問題に対処するために、私達は、固有名詞を同じ概念を表す言葉で自動的に置き換えるソフトウェアを作成しました。場合によっては、テキストを簡略化するために固有名詞は削除されます。たとえば、「レッドカーペットを歩く前ミスワールドのPriyanka Chopra」は「レッドカーペットの俳優」になるように人の名前を置き換えたり、「ロサンゼルスのコンサートで群衆は」は「コンサートで群衆は」と地名を削除します。また、名前による修飾も削除されます。例えば、「イタリア料理」は単に「料理」になりますし、必要に応じて新しく形成された名詞フレーズも修正します。例えば、「アーティストとアーティスト」は「アーティスト」になります。

テキスト修正の例。 CC BY 2.0ライセンスで使用されているRockoleandoの画像。オリジナルのキャプションは「Ray ManzarekとRobbie Kriegerのステージパフォーマンス」Conceptual Captions では「ハードロックアーティストのステージパフォーマンス」

最後に、全てエンティティ(概念、例えば、「アーティスト」、「犬」、「近所」など)をクラスタリングし、学習させるのに十分な量(100以上)を保持する概念のみに絞り込みました。これは、「人物」、「俳優」、「アーティスト」、「プレーヤー」、「イラストレーション」などの16,000の概念になりました。私たちが採用しなかった概念は「予算」、「手綱」、「締め切り」、「省庁」、「漏斗」など、それほど多くはありません。

300万以上のサンプル(拒絶率99.94%)の綺麗な学習可能な画像キャプションデータセットを得るために、約50億枚の候補画像を含む約10億の英文ウェブページが必要になりました。私たちの今回のモデルの制御パラメータは精度優先にしましたが、より精度の低い例をより大量に生成するように調整することもできます。

データセットのインパクト

データセットの有用性を確認するために、Tensor2Tensor(T2T)で実装されたRNNベースおよびTransformerベースの画像キャプショニングモデルを「MS-COCOデータセット」と「今回のConceptual Captionsデータセット」で学習させた性能評価試験結果を以下に示します。

モデルの構造の詳細については、論文を参照してください。それぞれのデータセットで学習したモデルは、Flickr30Kデータセット(MS-COCOおよびConceptual Captionsの両方とデータ領域が重複しない)の画像を使用してテストされ、出力されたキャプションは3人の人間の評価者によって評価されました。結果を以下の表に示します。

MS-COCOデータセット:画像1つに人間が付けた5つのキャプションを持つ120万件の画像データセット

Conceptual Captionsデータセット:画像1つに1つのキャプションを持つ330万件の画像データセット

| Model Architecture | Training Dataset | 人間により評価された割合(%) |

| RNN | COCO | 27.60% |

| T2T Transformer | COCO | 36.20% |

| RNN | Conceptual Captions | 41.80% |

| T2T Transformer | Conceptual Captions | 50.60% |

これらの結果から、Conceptual Captionsで訓練されたモデルは、アーキテクチャ(すなわち、RNNまたはTransformer)に関係なく、競合する他のデータセットよりも一般化(つまり特定のデータのみに対応できるのではなく様々な一般的なデータに対応できる優れた性能を持っている)されていると結論付けられます。

さらに、どちらのデータセットで学習させた場合でも、TransformerモデルがRNNより優れていることがわかりました。これらの調査結果から、Conceptual Captionsを使えば、さまざまな画像でより優れた画像キャプショニングモデルを学習させることができます。

挑戦者求む!

この新しいデータセットが機械学習コミュニティが画像キャプションモデルの最先端技術を進化させるのに役立たせる事が私たちの希望です。Conceptual Captionsは人間が人手で注釈をつける必要がないため、スケーラビリティが高い(つまり、規模を機械的に大きくする事ができる)のです。

重要な事は、このスケーラビリティを利用して、さらに幅広い種類の画像に対してAlt-text-HTMLのように注釈を自動的に作成できるようになる事です。関心のある人は全員、Concept Captions Challengeコンペに参加することをお勧めします。機械学習コミュニティがこれを使って何を成し遂げる事ができるのか楽しみにしています!詳細および最新の結果については、チャレンジウェブサイトをご覧ください。

謝辞

Conceptual Captionsデータセットを用いて人工知能を学習してくれたNan Ding、Sebastian GoodmanとBo Pang、そしてデータセットの一般公開を推進してくれたAmol Wankhedeに感謝します。

3.Conceptual Captions:自動収集された新しい画像データセット感想

これとAutoAugmentを使うと、ラベル付き画像データは膨大な量を作成できるようになりますね。機械学習を使って学習用データを増やして、その結果を使って更に品質の良い学習用データを増やして、と正の循環が始まってます。

4.Conceptual Captions:自動収集された新しい画像データセット関連リンク

1)ai.googleblog.com

Conceptual Captions: A New Dataset and Challenge for Image Captioning

2)aclweb.org

Conceptual Captions: A Cleaned, Hypernymed, Image Alt-text Dataset For Automatic Image Captioning

コメント