1.Shift-Robust GNN:データの偏りに堅牢なグラフニューラルネットワーク(3/3)まとめ

・ラベル付与されたサンプルが偏っている場合にSR-GNN正則化で30~40%の分類性能向上が可能

・グラフの畳み込みを高速化するために線形演算を用いた別種のGNNモデルの正則化も検討した

・深層GNNと線形GNNの両方を組み合わせた汎用的正則化に関する公式も論文内で発表している

2.線形GNNのShift-Robust正則化

以下、ai.googleblog.comより「Robust Graph Neural Networks」の意訳です。元記事は2022年3月8日、Bryan PerozziさんとQi Zhuさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Johnny Briggs on Unsplash

分布シフトが性能に与える影響

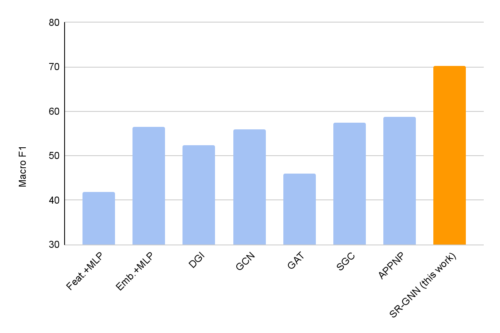

実験では、本手法と標準的なグラフニューラルネットワークモデルを比較し、ノード分類タスクにおける性能を測定しました。その結果、SR-GNN正則化を加えることで、偏った学習データラベルを持つ分類タスクにおいて、30~40%の改善が得られることを実証しました。

PubMedデータセットにおいて、偏った学習データを用いて学習した後のノード分類精度の比較

SR-GNNはDGI, GCN, GAT, SGC, APPNPを含む7つの比較対象より性能が優れています。

インスタンスの再重み付けによる線形GNNのShift-Robust正則化

さらに、グラフの畳み込みを高速化するために線形演算を用いた別種のGNNモデル(APPNP、SimpleGCNなど)があることも注目すべき点です。私達は、偏った学習データが存在する場合に、これらのモデルの信頼性を高める方法についても検討しました。

設計が異なるため、同じ正則化機構を直接適用することはできませんが、近似した真の分布からの距離に応じて学習実体(training instances)を再重み付けすることにより、学習の偏りを「修正」することができます。これにより、モデルは勾配を通さずに、偏った学習データの分布を修正することができます。

最後に、2つの正則化(深層GNNと線形GNNの両方)を組み合わせて、損失に対する汎用的正則化として、領域正則化とインスタンス再重み付け(instance reweighting)の両方を組み合わせることができます。(損失公式を含む詳細は論文に掲載されています)

まとめ

偏った学習データは実世界のシナリオではよくあることで、大量のデータのラベル付けの困難さ、ラベル付けのためのノード選択に用いられる様々な経験則や矛盾した手法、ラベル割り当ての遅れなど、様々な理由で発生しうるものです。私達は、偏った学習データの影響を低減できる汎用的なフレームワーク(SR-GNN)を提示し、深層GNNと最近の線形化(浅い)バージョンの両方を含む様々なタイプのGNNに適用できることを明らかにしました。

謝辞

Qi ZhuはUIUCの博士課程に在籍しています。Natalia Ponomareva (Google Research)とJiawei Han (UIUC)に感謝します。Tom Small と Anton Tsitsulin の視覚化に感謝します。

3.Shift-Robust GNN:データの偏りに堅牢なグラフニューラルネットワーク(3/3)関連リンク

1)ai.googleblog.com

Robust Graph Neural Networks

2)proceedings.neurips.cc

Shift-Robust GNNs: Overcoming the Limitations of Localized Graph Training Data(PDF)