1.機械学習トレーニング時の二酸化炭素排出量を4年間で747倍削減(1/2)まとめ

・機械学習実行時の計算コストの上昇と温室効果ガスの総排出量について懸念する声がある

・機械学習関連作業時の二酸化炭素排出量を大幅に削減する4つの主要な実践方法を実証した

・4Mと呼ぶこの手法はモデル、マシン、設備の高度化、地域の最適化からなる

2.二酸化炭素排出量を削減するためのベストプラクティス4M

以下、ai.googleblog.comより「Good News About the Carbon Footprint of Machine Learning Training」の意訳です。元記事は2022年2月15日、David Pattersonさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Callum Shaw on Unsplash

機械学習(ML:Machine Learning)がIT技術の中で目立つようになり、それに伴う計算コストの上昇、主にカーボンフットプリント(carbon footprint)、すなわち温室効果ガスの総排出量について懸念する声が上がっています。

これらの主張は、MLにおける炭素排出をめぐる議論を正しく盛り上げるものでありますが、真の二酸化炭素排出量を評価するための正確なデータの必要性も強調されており、これは、MLにおける二酸化炭素排出量を軽減するための戦略を特定するのに役立ちます。

IEEE Computerに掲載された「The Carbon Footprint of Machine Learning Training Will Plateau, Then Shrink」では、運用時の二酸化炭素排出量に着目しています。すなわち、データセンター内での間接的な排出量を含む、MLハードウェアの運用にかかるエネルギーコストです。

自然言語処理(NLP)モデルのトレーニング時に排出されるエネルギーコストに注目し、二酸化炭素排出量を削減するためのベストプラクティスを調査しました。私たちは、ML関連作業実施時の二酸化炭素(およびエネルギー)排出量を大幅に削減する4つの主要な実践方法を実証し、これらの手法によりGoogleの総エネルギー使用量の15%未満にMLの使用量を抑えました。

4Ms: エネルギーと二酸化炭素排出量を削減するためのベストプラクティス

私たちは、エネルギーと二酸化炭素の排出を大幅に削減する4つのベストプラクティスを特定しました。これらを「4M」と呼び、これらはすべて現在Googleで使用されており、Google Cloudサービスを使用しているすべての人が利用可能なものです。

(1)モデル(Model)

スパースモデルなどの効率的なMLモデルアーキテクチャを選択することで、計算量を3倍から10倍削減しながらML品質を向上させることができます。

(2)マシン(Machine)

汎用プロセッサではなく、ML のトレーニングに最適化されたプロセッサとシステムを使用することで、性能とエネルギー効率を 2 倍から 5 倍に向上させることができます。

(3)設備の高度化(Mechanization)

オンプレミスではなくクラウドでコンピューティングすることで、エネルギー使用量とそれによる排出量を1.4倍から2倍削減することができます。クラウドベースのデータセンターは、5万台のサーバーのエネルギー効率を高めるために装備された新しいカスタム設計の倉庫で、非常に優れた電力使用効率(PUE:Power Usage Effectiveness)を実現しています。オンプレミス型データセンターは、多くの場合、古くて小さいため、エネルギー効率の高い新しい冷却システムと配電システムでコストを減らす事ができません。

(4)地域の最適化(Map Optimization)

さらに、クラウドでは、顧客が最もクリーンなエネルギーを活用している場所を選ぶことができるため、総二酸化炭素使用量をさらに5倍から10倍削減することができます。場所の最適化を行うと、最も環境に優しい場所がすぐに満杯になってしまう事てしまうことを心配する人もいるかもしれませんが、効率的なデータセンターを求めるユーザーの要望により、グリーンデータセンターの設計と展開は継続的に進化していくことでしょう。

これら4つの実践を合わせると、エネルギーを100倍、排出量を1000倍削減することができます。

なお、Googleは業務で使用するエネルギーを100%再生可能エネルギーでまかなっています。従来の「カーボンオフセット(carbon offset)」のルールでは、排出した二酸化炭素量を他の場所で吸収した二酸化炭素を購入する事で賄う事ができます。通常、炭素排出の1年後まで遡及可能で、同じ大陸のどこからでも購入することができます。

Googleは、2030年までに、エネルギーが消費されるのと同じ送電網で24時間、100%カーボンフリーのエネルギーで運用するよう、すべてのエネルギー消費の脱炭素化を約束しています。Googleの一部のデータセンターは、すでに90%のカーボンフリーエネルギーで運用しており、全体平均では2019年に61%、2020年に67%のカーボンフリーエネルギーで運用しています。

以下では、実際に4Mを改善した場合の影響を説明します。

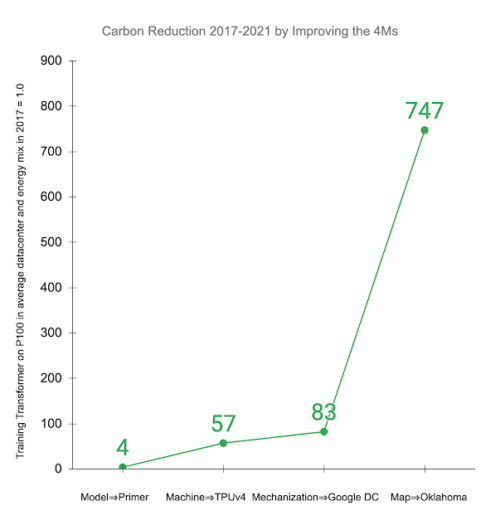

他の研究では、世界平均と一致する平均的なデータセンターとエネルギーミックスにおいて、Nvidia P100 GPUでTransformerモデルをトレーニングすることを検討しました。最近発表されたアーキテクチャであるPrimerは、Transformerと同じ精度を達成するために必要な計算を4倍削減します。

TPUv4のような新世代のMLハードウェアを使用すると、P100に比べてさらに14倍、全体では57倍もの改善が得られます。効率的なクラウドデータセンターでは、平均的なデータセンターに比べて1.4倍のエネルギー削減効果があり、その結果、全体で83倍のエネルギー削減が可能になります。さらに、低炭素エネルギー源のデータセンターを使用することで、二酸化炭素排出量をさらに9倍削減でき、4年間で合計747倍の二酸化炭素排出量削減を実現します。

他の研究で対象となった「2017年に平均的なデータセンターでP100 GPUでトレーニングしたTransformerモデル」に4Mベストプラクティスを適用した場合の総二酸化炭素換算排出量(CO2e)の削減量。表示される値は、モデルをPrimerに更新する、MLアクセラレータをTPUv4にアップグレードする、平均よりも優れたPUEを持つGoogleデータセンターを使用する、非常にクリーンなエネルギーを使用するGoogleオクラホマデータセンターでトレーニングするという4Mのそれぞれに連続して取り組んだ累積改善量です。

3.機械学習トレーニング時の二酸化炭素排出量を4年間で747倍削減(1/2)関連リンク

1)ai.googleblog.com

Good News About the Carbon Footprint of Machine Learning Training

2)www.techrxiv.org

The Carbon Footprint of Machine Learning Training Will Plateau, Then Shrink

3)arxiv.org

Primer: Searching for Efficient Transformers for Language Modeling