1.H01:人間の脳の一部をブラウザで閲覧可能な形式に再構築(2/2)まとめ

・人間の脳の三次元再構成結果はブラウザから3Dインターフェイスを通じて操作可能

・Neuroglancerと呼ばれるこのソフトはコネクトミクス コミュニティで使用されている

・より大きな脳を解析するためには圧縮と新たな操作インタフェースが必要になる見込み

2.蝿の脳から人間の脳へ

以下、ai.googleblog.comより「A Browsable Petascale Reconstruction of the Human Cortex」の意訳です。元記事の投稿は2021年6月1日、Tim BlakelyさんとMichał Januszewskiさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Robina Weermeijer on Unsplash

取り込んだ画像データ、三次元再構成結果、および注釈は、もともとショウジョウバエの脳を視覚化するために開発された、Neuroglancer と呼ばれるブラウザから操作可能なWeb ベースの 3D 視覚化インターフェイスを通じて表示できます。

Neuroglancer はオープンソース ソフトウェアとして入手可能であり、幅広いコネクトミクス コミュニティで広く使用されています。H01 データセットの分析をサポートするために、いくつかの新しい機能が導入されました。特に、タイプやその他の属性に基づいてデータセット内の特定のニューロンを検索するためのサポートです。

人間の皮質の分析

付属の論文では、H01 が人間の皮質の組織化のいくつかの興味深い側面を研究するためにどのように既に使用されているかを示しています。特に、新しい細胞型が発見され、「異常な」軸索入力の存在が発見され、標的樹状突起との強力なシナプス結合が確立されました。これらの発見は有望なスタートですが、H01 データセットの広大さは、人間の皮質に関心のある研究者による長年のさらなる研究の基礎を提供します。

H01の分析を加速するために、SimCLRを自己教師有りで学習させた亜種モデルを使用してトレーニングされたニューラル ネットワークによって生成された H01 データのembeddingsも提供します。

これらのembeddingsは、データセットの局所的な部分の非常に有益な特徴表現を提供し、新しい構造に迅速に注釈を付け、純粋にデータ駆動型の基準に従って脳構造をクラスタリングおよび分類する新しい方法を開発するために使用できます。Google Cloud TPU ポッドを使用してこれらのembeddingsをトレーニングし、ボリューム全体に広がる約40億のデータ位置で推論を実行しました。

圧縮手法を改善してデータセット サイズを管理

H01はペタバイト規模のデータセットですが、それでも人間の脳全体の100万分の1にすぎません。シナプス レベルの脳マッピングをマウスの脳全体(H01の500倍)に規模拡大するためには、まだ深刻な技術的課題が残っており、もちろん、人間の脳全体に規模拡大する事はもっと困難です。

これらの課題の1つはデータ保存手段です。マウスの脳はエクサバイト相当のデータを生成する可能性がありますが、そのデータを保存するにはコストがかかります。

ちまり、1エクサと仮定すると1000 x 1000 / 20T = 約5万台

5万台 * 8.5万円 = 42.5億円!?

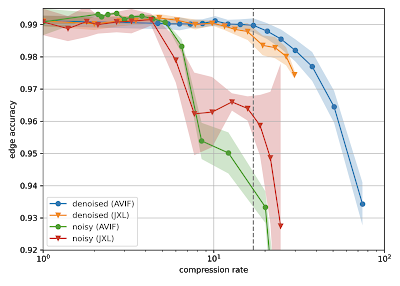

これに対処するために、本日、H01 などのデータを少なくとも1/17に圧縮する機械学習ベースのノイズ除去戦略を使用する方法を詳しく説明する論文「Denoising-based Image Compression for Connectomics」もリリースします。(下の図の破線)、この手法では自動再構成時の精度の損失はごくわずかです。

JPEG XL(JXL))およびAV Image Format(AVIF)コーデックの圧縮率の関数としてのノイズの多い画像とノイズ除去された画像の再構成品質。点と線は平均を示し、影付きの領域は平均の±1 標準偏差をカバーしています。

電子顕微鏡を使って画像化する際はランダムな変動があるため、原理的に圧縮が困難な画像ノイズが発生します。このノイズには、より少ないバイトで描写できる空間相関やその他の構造が欠けているためです。

そのため、まず、同じ組織片の画像を「高速」取得方式(大量のノイズが発生)と「低速」取得方式(ノイズ量が少ない)の両方で取得しました。次に、ニューラル ネットワークをトレーニングして、「高速」スキャン画像から「低速」スキャン画像を推論するように学習させました。

標準の画像圧縮コーデックで、生データと比較して人工的な効果の写り込みが少ない「仮想」低速スキャンに非可逆圧縮することができました。この進歩により、将来の大規模なコネクトミクス プロジェクトに関連するコストを大幅に削減できる可能性があると考えています。

次のステップ

しかし、問題は保存容量だけではありません。将来のデータ セットの巨大なサイズは、研究者がコネクトーム データに固有の豊富な情報を整理してアクセスするための新しい戦略を開発する必要があります。これらは、今後登場する脳マッピング データを人間が調査する際に新しい操作モードが必要となるという課題です。

3.H01:人間の脳の一部をブラウザで閲覧可能な形式に再構築(2/2)関連リンク

1)ai.googleblog.com

A Browsable Petascale Reconstruction of the Human Cortex

2)www.biorxiv.org

A connectomic study of a petascale fragment of human cerebral cortex

Denoising-based Image Compression for Connectomics

3)h01-release.storage.googleapis.com

A Browsable Petascale Reconstruction of the Human Cortex

4)h01-release-dot-neuroglancer-demo.appspot.com

neuroglancer

NeuroglancerはH01ボリュームと注釈を仲介します。ユーザーは、レイヤーとタイプに基づいて特定のセルを選択したり、セルの入力シナプスと出力シナプスを表示したりできます。