1.Translatotron 2:音声間直接翻訳アプローチの品質を更に改良(1/2)まとめ

・音声間翻訳システムは通常、音声認識や機械翻訳、音声合成を順番に適用して実現

・2019年には2言語間で翻訳元音声を翻訳先音声に直接翻訳できるTranslatotronを発表

・Translatotron 2は品質、自然さ、堅牢性において、元のTranslatotronを大幅に上回る

2.Translatotron 2とは?

以下、ai.googleblog.comより「High-Quality, Robust and Responsible Direct Speech-to-Speech Translation」の意訳です。元記事は2021年9月23日、Ye JiaさんとMichelle Tadmor Ramanovichさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Miguel Henriques on Unsplash

音声から音声に翻訳する事(S2ST:Speech-to-Speech Translation)は、世界中の人々の間の言語の壁を打ち破る鍵です。

自動S2STシステムは通常、音声認識システム、機械翻訳システム、および音声合成システムなどの各サブシステムを順番に適用する(カスケードする)事で実現されています。ただし、このようなカスケードシステムでは、待ち時間が長くなり、情報(特に韻律、音程などのパラ言語情報や非言語情報)が失われたり、サブシステム間でのエラー処理が複雑になる可能性があります。

2019年には、2つの言語間で翻訳元音声から翻訳先音声に直接翻訳できる初めてのモデルであるTranslatotronを発表しました。

この直接S2STモデルは、効率的に直接トレーニングすることができ、翻訳後音声に元の話者の声色(非言語情報)を保持する独自の機能も備えていました。

ただし、自然に聞こえる翻訳された音声を忠実に生成する能力にもかかわらず、強力な比較対象モデルであるカスケード型S2STシステム(たとえば、直接音声から文章に翻訳するspeech-to-textモデルとそれに続くTacotron 2のTTSモデルの組み合わせで構成されます)と比較して依然としてパフォーマンスが劣っています。

論文「Translatotron 2: Robust direct speech-to-speech translation」では、Translatotronの改良版について説明します。

これは、元の話者の音声を翻訳された音声に転送するための新しい方法を適用しながら、パフォーマンスを大幅に向上させます。

改良された音声転送(voice transference)アプローチは、入力元音声内で複数の話者が順番に話している場合でも成功しますが、誤用の可能性を減らし、AIの原則との整合性を高めます。

3つの異なるデータを使った実験により、Translatotron 2は、翻訳品質、音声の自然さ、および音声の堅牢性において、元のTranslatotronよりも大幅に優れていることが一貫して示されました。

Translatotron 2

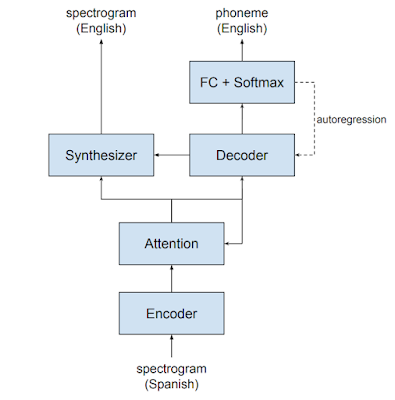

Translatotron 2は、4つの主要部品から構成されています。

音声エンコーダー、ターゲット音素デコーダー、ターゲット音声シンセサイザー、およびこれらを相互に接続するアテンションモジュールです。

エンコーダー、アテンションモジュール、およびデコーダーの組み合わせは、良くある「音声からテキストに直接翻訳(ST:Speech-to-Text)」モデルに似ています。シンセサイザーは、デコーダーとアテンションの両方からの出力に条件付けされています。

Translatotron 2のモデルアーキテクチャ(スペイン語の音声を英語の音声に直接翻訳する)

TranslatotronとTranslatotron2の間には、パフォーマンスを向上させるための重要な要素として3つの新しい変更があります。

(1)ターゲット音素デコーダーからの出力は、元のTranslatotronでは補助損失としてのみ使用されますが、Translatotron 2ではスペクトログラムシンセサイザーへの入力の1つとなります。この強力な調整により、Translatotron 2のトレーニングが容易になり、パフォーマンスが向上します。

(2)オリジナルのTranslatotronのスペクトログラムシンセサイザーは、Tacotron 2 TTSモデルと同様に注意ベース(attention-based)であり、そのため、Tacotron2と同じ堅牢性の問題を抱えています。対照的に、Translatotron2で採用されているスペクトログラムシンセサイザーは持続時間ベース(duration-base)です。Non-Attentive Tacotronで使用されているものと同様であるため、合成された音声の堅牢性が大幅に向上します。

(3)TranslatotronとTranslatotron2はどちらも、エンコードされた元音声に対して注意ベースの接続を使用します。ただし、Translatotron 2では、この注意はスペクトログラムシンセサイザーではなく音素デコーダーによって駆動されます。これにより、スペクトログラムシンセサイザーが見る音響情報が、シンセサイザーが合成する翻訳されたコンテンツと一致するようになり、各話者が発言している間に各話者の声を保持するのに役立ちます。

より強力で責任ある声の保持

オリジナルのTranslatotronは、特定話者専用の話者エンコーダーから生成された話者embeddingでデコーダーを調整することにより、翻訳先音声で元の話者の音声を使用することができました。

ただし、このアプローチでは、特定の話者の音声録音データの一部が話者エンコーダーの参照オーディオとして使用された場合、または元話者のembeddingが直接利用可能な場合、翻訳された音声を別の話者の音声で生成することもできました。この機能は強力でしたが、任意のコンテンツ内で音声のなりすまし(spoof)に悪用される可能性があり、製品として発表する際に悪用の懸念がありました。

これに対処するために、言語理解と音声捕捉の両方を担当する単一の音声エンコーダのみを使用するようにTranslatotron2を設計しました。このように、訓練されたモデルは、元話者以外の音声を再生するように指示することはできません。このアプローチは、元のTranslatotronにも適用できます。

1.Translatotron 2:音声間直接翻訳アプローチの品質を更に改良(1/2)関連リンク

1)ai.googleblog.com

High-Quality, Robust and Responsible Direct Speech-to-Speech Translation

2)arxiv.org

Translatotron 2: Robust direct speech-to-speech translation

3)google-research.github.io

Audio samples from “Translatotron 2: Robust direct speech-to-speech translation”