1.SpineNet:ニューラルアーキテクチャ探索で発見された新しい物体検出アーキテクチャ(2/2)まとめ

・ニューラルアーキテクチャ探索の出発点となるモデルにはResNet-50バックボーンを採用

・発見されたスケール交換モデルは、物体検出タスクでResNet-50-FPNよりも平均精度が2.9%向上

・分類タスクにも転移可能でiNaturalist画像分類データセットで5%のtop-1精度の向上を達成

2.SpineNetとは?

以下、ai.googleblog.comより「SpineNet: A Novel Architecture for Object Detection Discovered with Neural Architecture Search」の意訳です。元記事の投稿は2020年6月30日、Xianzhi DuさんとJaeyoun Kimさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Tadeusz Lakota on Unsplash

ニューラルアーキテクチャ探索(NAS:neural architecture search)の出発点となるモデルにはResNet-50バックボーンを採用しました。最初にスケール交換とクロススケール接続を学習します。

探索空間内の全ての候補モデルの計算量はResNet-50とほぼ同じです。候補となるモデルはResNet-50の機能ブロックの順序を並べ替えるだけだからです。

発見されたスケール交換モデルは、物体検出タスクでResNet-50-FPNよりも平均精度(AP)が2.9%優れています。

探索オプションを追加して各候補の機能ブロックのスケールとタイプ(ResNetモデル群で使われる残差ブロックやボトルネックブロックなど)を調整することにより、効率をさらに改善(-10%FLOP)できます。

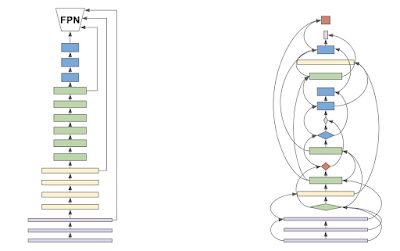

学習した49層のスケール交換バックボーンアーキテクチャをSpineNet-49と呼びます。SpineNet-49は、ブロックを2回、3回、または4回繰り返して特徴次元を増やすことで、SpineNet-96 / 143 / 190にさらに拡張できます。ResNet-50-FPNと最終的なSpineNet-49のアーキテクチャ比較を以下に示します。

ResNetバックボーン(左)とニューラルアーキテクチャ探索から派生したSpineNetバックボーン(右)のアーキテクチャ比較

パフォーマンス

ResNet-FPNとの比較を通じて、SpineNetモデルのパフォーマンスを示します。 同様の構成要素を使用して、SpineNetモデルは、10~20%少ない計算量(FLOP)でありながら、ResNet-FPNの対応モデルをさまざまなスケールで最大3%、APで上回ります。

特に、最大モデルであるSpineNet-190は、推論中にマルチスケールに関するテストがなくとも、単一モデルでCOCOに対して52.1%APを達成し、従来の検出器を大幅に上回っています。

SpineNetは分類タスクにも転移可能で、挑戦的なiNaturalistのきめ細かい画像分類データセットで5%のtop-1精度の向上を達成しました。

| input size | FLOPs(B) | Parameters(M) | Box AP(%) | |

| R50-FPN | 640×640 | 96.8 | 34.0 | 40.4 |

| SpineNet-49 | 640×640 | 85.14(-12%) | 28.5(-16%) | 42.8(+2.4) |

| R101-FPN | 1024×1024 | 325.9 | 53.1 | 43.9 |

| SpineNet-96 | 1024×1024 | 265.4(-18%) | 43.0(-19%) | 46.8(+2.9) |

| R152-FPN | 1280×1280 | 630.9 | 68.7 | 45.2 |

| SpineNet-143 | 1280×1280 | 524.4(-17%) | 66.9(-3%) | 48.0(+2.8) |

| SpineNet-190 | 1280×1280 | 1885.0 | 163.6 | 52.1 |

SpineNetモデルとResNet-FPNモデルのパフォーマンス比較

COCOの境界ボックス検出にRetinaNet検出フレームワークを使用

| FLOPs(B) | Parameters(M) | ImageNet Top-1(%) | iNaturalist Top-1(%) | |

| ResNet-34 | 3.7 | 21.8 | 74.4 | 54.1 |

| ResNet-50 | 4.1 | 25.6 | 77.1 | 54.6 |

| SpineNet-49 | 3.5(-15%) | 22.1(-14%) | 77.0(-0.1) | 59.3(+4.7) |

| ResNet-101 | 7.8 | 44.6 | 78.2 | 57.0 |

| SpineNet-96 | 5.7(-27%) | 36.5(-18%) | 78.2(同上) | 61.7(+4.7) |

| ResNet-152 | 11.5 | 60.2 | 78.7 | 58.4 |

| SpineNet-143 | 9.1(-21%) | 60.5(+0.5%) | 79.0(+0.3) | 63.6(+5.2) |

SpineNetモデルとResNetモデルのパフォーマンス比較

ImageNet分類とiNaturalistのきめ細かい画像分類を使用

まとめ

本研究では、デコーダネットワークを使用しても、従来のスケール減少モデルは画像内の物体の認識と位置特定を同時に行うタスクには効果的でない事を確認しました。

この問題に対処するために、新しいメタアーキテクチャであるスケール交換モデルを提案します。スケール交換モデルの有効性を証明するために、物体検出用のニューラルアーキテクチャ探索によってSpineNetを見出し、画像分類に直接使用できることを示します。 将来的には、スケール交換モデルが、検出と分類を超えた多くの視覚的タスクにわたるバックボーンのメタアーキテクチャ設計になる事を願っています。

謝辞

論文の共著者に特に感謝します。

Tsung-Yi Lin, Pengchong Jin, Golnaz Ghiasi, Mingxing Tan, Yin Cui, Quoc V. Le, 及び Xiaodan Song。

また、Yeqing Li, Youlong Cheng, Jing Li, Jianwei Xie, Russell Power, Hongkun Yu, Chad Richards, Liang-Chieh Chen, Anelia Angelova、および沢山のGoogle Brain Teamのご協力に感謝いたします。

3.SpineNet:ニューラルアーキテクチャ探索で発見された新しい物体検出アーキテクチャ(2/2)関連リンク

1)ai.googleblog.com

SpineNet: A Novel Architecture for Object Detection Discovered with Neural Architecture Search

2)arxiv.org

SpineNet: Learning Scale-Permuted Backbone for Recognition and Localization

3)github.com

models/official/vision/detection/

tpu/models/official/detection/

コメント