1.Form2Fit:物体の分解と組立てを行う事でロボットが組合わせの概念を学習(3/3)まとめ

・Form2Fitは組立キットの回転や変化、混在した状況、学習時に見た事がない部品などにも対応可能

・回転、空間的方向、物体の同一形状などを学習できている事がt-SNEを使って検証された

・現在のForm2Fitは平面的な組立作業のみに対応しており立体的な組立作業は今後の建久課題となる

2.Form2Fitの一般化

以下、ai.googleblog.comより「Learning to Assemble and to Generalize from Self-Supervised Disassembly」の意訳です。元記事の投稿は2019年10月31日、Kevin ZakkaさんとAndy Zengさんによる投稿です。

一般化した結果

実験の結果は、組立作業を一般化するポリシー学習に関する大きな可能性を示しています。例えば、特定の1つの位置と方向のみで組立キットを組み立てるようにポリシーがトレーニングされている場合でも、90%の確率でキットのランダムな回転と移動に対応して組み立てることができます。

Form2Fitポリシーは、組立キットの幅広い回転及び変化に対して堅牢です。

また、Form2Fitは、トレーニング中に未見な新しい構成に対応可能な事もわかりました。 例えば、2つの部品で(絹綿とテープ)でポリシーをトレーニングすると、これらの部品の新しい組合せと混合物を、そのような構成をこれまで見たことがない場合でも、正確に組み立てることができます。

Form2Fitポリシーは、同じ組立キットの複数のバージョンや異なる組立キットの混合など、見た事がない新しい組立キットの構成に一般化できます。

更に、トレーニングされていない完全に新しい組立キットが提供されると、Form2Fitは学習した形状を元に一般化し、86%を超える組立精度でそれらのキットを組み立てることができます。

Form2Fitポリシーは、見た事がない単一部品、もしくは及び複数部品で構成される組立キットに一般化できます。

記述子は何を学習しているのでしょうか?

Form2Fitのマッチングネットワークの記述子がエンコードしている学習内容を確認するために、t-SNEと呼ばれるembedding視覚化手法を使用して、様々な物体の画素単位の記述子をRGB色空間で視覚化しました。

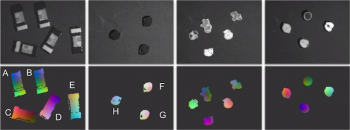

学習したオブジェクト記述子のt-SNEによるembedding視覚化。同じカテゴリの同じ向きのオブジェクトは同じ色(A、BまたはF、Gなど)を表示し、異なるオブジェクト(C、Hなど)と同じオブジェクトで異なる向き(A、C、DまたはH、Fなど)は異なる色を表示しています。

記述子は

(a)回転をエンコードすることを学習したことがわかります。

異なる向きの物体には異なる記述子(A、C、D、E)と(H、F)が割り当てられています。

(b)空間的方向をエンコードすることを学習したことがわかります。

同じ方向の物体上の同じポイントには、同様の記述子(A、B)および(F、G)が割り当てられています。

(c)物体の形状の同一性をエンコードすることを学習したことがわかります。

上図の3列目および4列目の動物の形状や果物の形状には固有の記述子が割り当てられています。

現在の制限と今後の研究

Form2Fitの結果は有望ですが、その限界は将来の作業の方向性を示唆しています。

私達の今回の実験は、2次元の平面形状を対象に作業する事を想定しており、この組立キットの制約により、真上から部品を掴み、そして真下に配置する事で組立作業を完了できるようにしています。

この制約の元では、現実世界の組立作業に対応できない場合があります。例えば、止め釘を45度の角度で正確に挿入する必要がある場合などです。Form2Fitを三次元的組立作業のより複雑なアクション表現に拡張することは興味深い事でしょう。

本研究の詳細とプログラムコードは、GitHubリポジトリからダウンロードできます。

謝辞

この研究は、Kevin Zakka, Andy Zeng, Johnny Lee, 及びShuran Song(コロンビア大学)によって行われました。特に、実りある技術的な議論をしてくれたNick Hynes, Alex Nichol,及びIvan Krasinに感謝します。

ハードウェアサポートに関して、Adrian Wong, Brandon Hurd, Julian SalazarそしてSean Snyderに、価値ある管理的サポートに関してRyan Hickman、執筆に関する有益なフィードバックに関してChad Richardsに感謝します。

3.Form2Fit:物体の分解と組立てを行う事でロボットが組合わせの概念を学習(3/3)関連リンク

1)ai.googleblog.com

Learning to Assemble and to Generalize from Self-Supervised Disassembly

2)form2fit.github.io

Form2Fit: Learning Shape Priors for Generalizable Assembly from Disassembly

コメント