1.Evolved Transformer:AutoMLにより進化したTransformer(2/2)まとめ

・Evolved Transformerがオリジナルと比較してパフォーマンスが最も向上するのは小さいパラメータサイズ

・Evolved Transformerはパラメータを効率的に使用しているためにパラメータサイズ効率が良い

・Evolved TransformerはTensor2Tensorの一部としてオープンソース化されシーケンスデータの問題に適用化

2.Evolved Transformerの性能

以下、ai.googleblog.comより「Applying AutoML to Transformer Architectures」の意訳です。元記事の投稿は2019年6月14日、David Soさんによる投稿です。

エンコーダとデコーダのアーキテクチャはNAS実行時には共有されていないため、これは特に興味深い特徴です。この設計の強みと言える分岐アーキテクチャーは、エンコーダーとデコーダーの両方で有用であることが判明しました。オリジナルのTransformerはもっぱら自己注意(self-attention)に頼っていましたが、Evolved Transformer(ET)は自己注意と広い畳み込み(wide convolution)の両方の長所を活用するハイブリッドです。

Evolved Transformerの性能評価

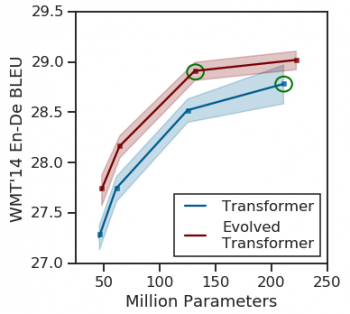

この新しいアーキテクチャの有効性をテストするために、アーキテクチャ探索時に使用した英語 – ドイツ語翻訳タスクに関して、元のTransformerと比較しました。

Evolved Transformerは、全てのパラメータサイズでBLEUとパープレキシティ(Perplexity:単語絞り込み性能)のパフォーマンスが向上し、モバイルデバイスで使用されているサイズに近しいサイズ(最大700万パラメータ)で最大の向上を示し、パラメータを効率的に使用している事を実証しました。

より大きなサイズでは、Evolved TransformerはWMT’14 En-Deで29.8のBLEUスコア、29.2のSacreBLEUスコアを達成し、最先端のパフォーマンスを示しました。

WMT’14 En-Deを用いて様々なサイズでEvolved TransformerとオリジナルのTransformerの比較結果

パフォーマンスが最も向上するのは小さいサイズです。しかし、ETは大きいサイズでも強力であり、37.6%少ないパラメータ数でも最大パラメータ数の従来型Transformerより優れています。(比較対象としたモデルは緑丸で囲まれています)。正確な数値については、私たちの論文の表3を参照してください。

一般化性能をテストするために、追加のNLPタスクでETとTransformerを比較しました。まず、異なる言語を翻訳させて結果を調べたところ、ETはパフォーマンスの向上を示し、その性能差は英語-ドイツ語で見られた差と似ていました。繰り返しになりますが、パラメータが効率的に使用されているため、中規模サイズのモデルで最大の改善が見られました。

また、LM1Bを使用した言語モデリングで両方のモデルのデコーダを比較したところ、2パープレキシティのパフォーマンスの改善が見られました。

| TASK | SIZE | PERP(Transformer) | PERP(Evolved Transformer) | BLEU(Transformer) | BLEU(Evolved Transformer) |

| WMT’14 EN-FR | BASE | 3.61±0.01 | 3.42±0.01 | 40.0±0.1 | 40.6±0.1 |

| WMT’14 EN-FR | BIG | 3.26±0.01 | 3.13±0.01 | 41.2±0.1 | 41.3±0.1 |

| WMT’14 EN-CS | BASE | 4.98±0.04 | 4.42±0.04 | 27.0±0.1 | 27.6±0.1 |

| WMT’14 EN-CS | BIG | 4.43±0.01 | 4.38±0.01 | 28.1±0.1 | 28.2±0.1 |

| LM1B | BIG | 30.44±0.04 | 28.60±0.03 | – | – |

今後の研究

今回の研究結果は、フィードフォワードシーケンスモデルのアーキテクチャを探索する最初のステップです。Evolved TransformerはTensor2Tensorの一部としてオープンソース化されており、シーケンスデータの問題解決に使用できます。研究結果を再現できるようにするため、私達がアーキテクチャ探索時に使用した探索スペースとプログレッシブダイナミックハードルを実装したColabもオープンソース化しています。私たちは、研究コミュニティが新しいモデルを使って何をするのか見る事を楽しみにしています。そして、皆さんがこれらの新しい検索テクニックを使って新たにモデルを再構築できる事を願っています!

3.Evolved Transformer:AutoMLにより進化したTransformer(2/2)関連リンク

1)ai.googleblog.com

Applying AutoML to Transformer Architectures

2)arxiv.org

The Evolved Transformer

3)github.com

tensor2tensor/tensor2tensor/models/evolved_transformer.py

コメント