1.SmeLU:ディープラーニングの再現性を悪化させている犯人はReLU関数(3/3)まとめ

・SmeLUは推薦システムにおいてその再現性を高める事や学習と推論の効率を向上させる

・滑らかな活性化を用いる事で精度など他の重要な指標を低下させることなく再現性を向上可能

・SmeLUは数学的に単純で実装が容易であり、安価で誤差が少ないという利点を持つ

2.SmeLUの性能

以下、ai.googleblog.comより「Reproducibility in Deep Learning and Smooth Activations」の意訳です。元記事は2022年4月5日、Gil ShamirさんとDong Linさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by photo_ reflect on Unsplash

パフォーマンス

SmeLUは複数のシステム、特に推薦システムにおいて、推薦順が入れ替わる率などを低減し、その再現性を高めることに貢献しています。

SmeLUはReLUと比較して精度が向上する一方で、精度を犠牲にすることで再現不能性を緩和するアンサンブルのようなコストのかかる手法を置き換えることができます。

さらに、疎な推薦システム(sparse recommendation systems)のアンサンブルを置き換えることで、アンサンブルの各構成要素の推論を生成するために必要となる、モデルパラメータを複数回検索する必要性を減らすことができます。これにより、学習と推論の効率が大幅に改善されます。

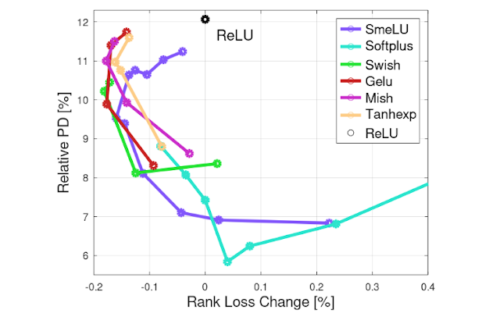

滑らかな活性化(Smooth activations)の利点を説明するために、異なる活性化について、ある損失の変化の関数として、相対予測差(PD:Prediction Difference)をグラフ化しました。

相対予測差は、2つのモデルの予測値の差の絶対値と、その予測値の期待値の比であり、全ての評価サンプルの平均と定義します。私達は、大規模なシステムにおいて、非常に一貫した結果を得るためには、2つのモデルのみを考慮することで十分であり、かつ安価であることを観察しています。

下図は、PD-精度の損失平面上のカーブです。再現性については、曲線が低いほど良く、精度については、左側ほど良いということになります。滑らかな活性化は、ReLUと比較してPDを約50%削減することができ、かつ精度を向上させることができる可能性があります。SmeLUは他のスムースアクティブと同等の精度が得られるが、より再現性が高く(PDが低く)、なおかつReLUより精度が高いです。

推薦システムにおいて、各項目がどの程度正確にランク付けされているかを示す評価ランキング損失の変化率(値が大きいほど精度が悪い)の関数としての相対PD(活性度を変えた場合)

結論と今後の課題

私達は、実世界の実用的なシステムにおける再現不能性の問題を示し、それがユーザーやシステム・モデル設計者にどのような影響を与えるかを示しました。

研究結果の再現性の欠如を解決しようとするとき、この特別な問題はほとんど注目されてきませんでしたが、再現不能性は重要な問題となり得ます。私達は、モデルの精度など他の重要な指標を低下させることなく、滑らかな活性化を用いるという単純な解決策で、この問題を大幅に軽減できることを実証しました。

私達は、数学的に単純で実装が容易であり、安価で誤差が少ないという利点を持つ、新しい滑らかな活性化関数、SmeLUを実証しました。

再現性、特に最適化目標が凸でないディープネットワークにおける再現性を理解することは未解決の問題です。最近、より単純な凸の場合の最初の理論的枠組みが提案されましたが、ディープネットワークに依存する実用的なシステムに適用できるこの問題のより良い理解を得るためには、さらに研究を進めることが必要です。

謝辞

Sergey IoffeにはSmeLUに関する初期の議論を、Lorenzo CovielloとAngel YuにはSmeLUの初期適用を、Shiv Venkataramanにはこの研究のスポンサーを、Claire Cuiには初期からの議論とサポートを、Jeremiah Willcock, Tom Jablin, Cliff Youngには実装をサポートしてもらったことに感謝します。

Yuyan Wang, Mahesh Sathiamoorthy, Myles Sussman, Li Wei, Kevin Regan, Steven Okamoto, Qiqi Yan, Todd Phillips, Ed Chi, Sunita Verna, その他多くの方々に多くの有益な議論を提供していただきました。

Matt StreeterとYonghui Wuには論文とこの投稿へのフィードバックを、Tom Smallにはこの投稿のイラストを手伝って頂きました。

3.SmeLU:ディープラーニングの再現性を悪化させている犯人はReLU関数(3/3)関連リンク

1)ai.googleblog.com

Reproducibility in Deep Learning and Smooth Activations

2)arxiv.org

Real World Large Scale Recommendation Systems Reproducibility and Smooth Activations