1.PaLM:5400億パラメータを持つ革新的なパスウェイ言語モデル(3/3)まとめ

・PythonコードのみのデータセットでPaLMを微調整するとさらなる性能向上を確認できた

・規模拡大可能な巨大言語モデルの誤用対策は現在進行中の課題で透明性に留意している

・Pathways ヴィジョンの単一AIシステムがあらゆるタスクを上手にこなす未来に近づいている

2.PaLM-Coder

以下、ai.googleblog.comより「Pathways Language Model (PaLM): Scaling to 540 Billion Parameters for Breakthrough Performance」の意訳です。元記事は2022年4月4日、Sharan NarangさんとAakanksha Chowdheryさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Stephen Leonardi on Unsplash

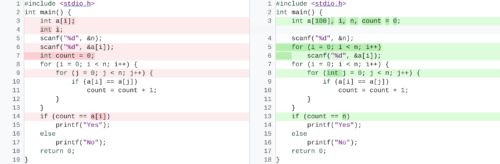

また、PythonコードのみのデータセットでPaLMを微調整(PaLM-Coderと呼んでいます)することで、さらなる性能向上が確認されています。DeepFixと呼ばれるコード修復タスクの例では、最初に不具合のある壊れたCプログラムをコンパイルが成功するまで修正することが目的ですが、PaLM-Coder 540Bは82.1%のコンパイル成功率を達成し、従来の71.7%を上回る素晴らしい性能を実証しています。これにより、ソフトウェア開発時に発生する、より複雑なエラーの修正に対応できる可能性が出てきました。

DeepFixのコード修復タスクの一例

微調整されたPaLM-Coder 540Bは、コンパイルエラー(左、赤色)をコンパイルできるバージョンのコードに修正します(右)

倫理的配慮

最近の研究により、ウェブ上のテキストで学習したLLMに関連する様々な潜在的リスクが浮き彫りになっています。モデルカードやデータシートのような透明性確保を通して、そのような潜在的な望ましくないリスクを分析し、文書化することは非常に重要であり、そこには使用目的やテストに関する情報も含まれています。

この目的のために、私達の論文はデータシート、モデルカード、およびResponsible AIベンチマークの結果を提供し、データセットとモデル出力の偏りやリスクに関する徹底した分析を報告している。この分析は、モデルの潜在的なリスクを概説するのに役立ちますが、起こりうる害を真に校正し、文脈を特定し、軽減するためには、領域およびタスクに特化した分析が必要不可欠です。このようなモデルのリスクと利点をさらに理解することは、言語モデルの悪意ある使用に対するガードレールを設置できる規模拡大可能な解決策の開発とともに、現在進行中の研究のトピックです。

まとめと今後の課題

PaLMは、密なデコーダのみのTransformerモデルで、よく研究され、確立されたレシピで5,400億のパラメータモデルを効率的にトレーニングすることにより、2つのTPU v4 Podsにまたがる数千のアクセラレータチップでモデルの規模を拡大するPathwaysシステムの能力を実証しています。

モデル規模の限界に挑戦することで、様々な自然言語処理、推論、コードタスクにおいて、PaLMの画期的な少数ショット学習性能が実現されます。

PaLMは、モデルの規模を拡大し、新しいアーキテクチャの選択および学習スキームを組み合わせることで、より高性能なモデルへの道を開き、Pathways ヴィジョンに近づいています。

「1つのAIシステムが何千、何百万ものタスクを扱う事が出来るようになり、様々なタイプのデータを理解し、それを驚くべき効率で実行できるようにする」というものです。

謝辞

PaLMは、GoogleリサーチとAlphabetの多くのチームによる大規模な共同作業の結果です。PaLMチーム全員の貢献に感謝します。

Jacob Devlin, Maarten Bosma, Gaurav Mishra, Adam Roberts, Paul Barham, Hyung Won Chung, Charles Sutton, Sebastian Gehrmann, Parker Schuh, Kensen Shi, Sasha Tsvyashchenko, Joshua Maynez, Abhishek Rao, Parker Barnes, Yi Tay, Noam Shazeer, Vinodkumar Prabhakaran, Emily Reif, Nan Du, Ben Hutchinson, Reiner Pope, James Bradbury, Jacob Austin, Michael Isard, Guy Gur-Ari, Pengcheng Yin, Toju Duke, Anselm Levskaya, Sanjay Ghemawat, Sunipa Dev, Henryk Michalewski, Xavier Garcia, Vedant Misra, Kevin Robinson, Liam Fedus, Denny Zhou, Daphne Ippolito, David Luan, Hyeontaek Lim, Barret Zoph, Alexander Spiridonov, Ryan Sepassi, David Dohan, Shivani Agrawal, Mark Omernick, Andrew Dai, Thanumalayan Sankaranarayana Pillai, Marie Pellat, Aitor Lewkowycz, Erica Moreira, Rewon Child, Oleksandr Polozov, Katherine Lee, Zongwei Zhou, Xuezhi Wang, Brennan Saeta, Mark Diaz, Orhan Firat, Michele Catasta および Jason Wei。

PaLMはGoogleの多くのチームによる研究の上に成り立っており、特にT5Xチーム、Pathwaysインフラチーム、JAXチーム、Flaxformerチーム、XLAチーム、Plaqueチーム、Borgチーム、Datacenterネットワークインフラチームに感謝したいと思います。

このブログ記事の共著者である Alexander Spiridonov と Maysam Moussalem、およびこのブログ記事の画像とアニメーションを提供してくれた Josh Newlan と Tom Small に感謝します。

最後に、このプロジェクトのアドバイザーに感謝します。Noah Fiedel、Slav Petrov、Jeff Dean、Douglas Eck、Kathy Meier-Hellsternの各氏に感謝します。

3.PaLM:5400億パラメータを持つ革新的なパスウェイ言語モデル(3/3)関連リンク

1)ai.googleblog.com

Pathways Language Model (PaLM): Scaling to 540 Billion Parameters for Breakthrough Performance

2)arxiv.org

PaLM: Scaling Language Modeling with Pathways