1.C4_200M:文法エラー訂正用の合成データセット(1/2)まとめ

・文法エラー修正とは、正しい文法やスペルを提案するため書き込みエラーをモデル化する試み

・近年GECの品質は大幅に向上したがこれは「翻訳」タスクを真似たアプローチをしたため

・しかしGECで利用可能なデータは少なくユーザーがやりがちなタイプのエラーと分布も異なる

2.C4_200Mとは?

以下、ai.googleblog.comから「The C4_200M Synthetic Dataset for Grammatical Error Correction」の意訳です。元記事の投稿は2021年8月10日、Felix StahlbergさんとShankar Kumarさんによる投稿です。

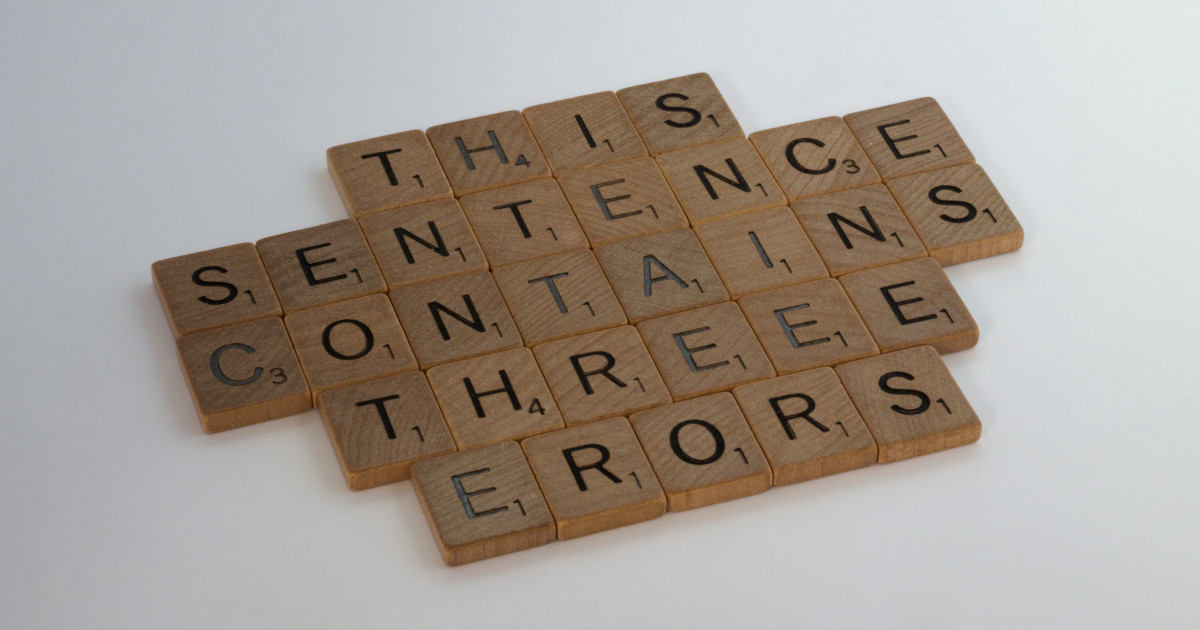

アイキャッチ画像の「This sentence contains threee erors」という文には様々な亜種があるようなのですが、3つ目のエラーが何かわかります?

回答

文中には2つしかエラーがないの3つあると言っている自体が3番目のエラーと言う事であるらしいです。クレジットはPhoto by Brett Jordan on Unsplash

文法エラー修正(GEC:Grammatical Error Correction)は、正しい文法やスペルを提案するために、文法や他のタイプの書き込みエラーをモデル化しようとする試みです。これにより、文書、電子メール、ブログ投稿、さらには私的なチャットの文章出力の品質を向上させる事ができます。

過去15年間で、GECの品質は大幅に向上しました。これは、この問題を「翻訳」タスクとして作り直したことによるところが大きいと考えられます。たとえば、Googleドキュメントで導入された際、このアプローチにより、ユーザに提案して受け入れられた文法エラー訂正数が大幅に増加しました。

しかしながら、GECモデルの最大の課題の1つは、利用可能なデータが多くない事です。音声認識や機械翻訳などの他の自然言語処理(NLP:Natural Language Processing)タスクとは異なり、英語などのリソースの多い言語であっても、GECで利用できるトレーニングデータは非常に限られています。

これに対する一般的な解決策は、経験側ベースのランダムな単語レベルまたは文字レベルで文章を破損させる事からモデルベースのアプローチまで、さまざまな手法を使用して合成データを生成することです。ただし、このような方法は単純化される傾向があり、実際のユーザーがやりがちなタイプのエラーの分布を反映していません。

EACLの「第16回教育アプリケーション構築のためのNLPの革新的使用に関するワークショップ」で発表された「Synthetic Data Generation for Grammatical Error Correction with Tagged Corruption Models」では、「タグ付き破損モデル(tagged corruption models)」を紹介します。

機械翻訳用の一般的な逆翻訳データ合成技術に触発されたこのアプローチにより、合成データ生成の正確な制御が可能になり、現実世界で見られるエラーの分布とより一貫性のある多様な出力が保証されます。

タグ付き破損モデルを使用して、新しい2億文のデータセットを生成しました。これは、GECの現実的な事前トレーニングデータを研究者に提供するためにリリースされました。この新しいデータセットをトレーニングパイプラインに統合することで、GECのベースラインを大幅に改善することができました。

タグ付き破損モデル

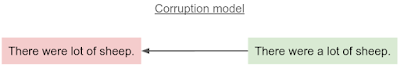

従来の破損モデルをGECに適用する背後にある考え方は、文法的に正しい文から開始し、エラーを追加することによってそれを「破損(corrupt)」させることです。破損モデルは、既存のGECデータセットの翻訳元センテンスと翻訳先センテンスを切り替えることで簡単にトレーニングできます。これは、以前の調査で、改善されたGECデータセットの生成に非常に効果的であることが示されています。

従来の破損モデルは、クリーンな入力文(緑)が与えられると、文法的に誤った文(赤)を生成します。

3.C4_200M:文法エラー訂正用の合成データセット(1/2)関連リンク

1)ai.googleblog.com

The C4_200M Synthetic Dataset for Grammatical Error Correction

2)aclanthology.org

Synthetic Data Generation for Grammatical Error Correction with Tagged Corruption Models

3)github.com

google-research-datasets / C4_200M-synthetic-dataset-for-grammatical-error-correction