1.RetinaGAN:シミュレーション環境から現実世界への転移を一般化(2/2)まとめ

・RL-CycleGAN は「タスクレベルの物体認識」を使用してsim-to-realギャップを超える

・RetinaGANは「ロボットの物体認識」に着目しタスクにもアルゴリズムにも依存しない

・RetinaGANは合成画像を現実画像に見えるように変換しsim-to-realギャップを超える

2.RetinaGANとは?

以下、ai.googleblog.comより「Toward Generalized Sim-to-Real Transfer for Robot Learning」の意訳です。元記事は2021年6月3日、Daniel HoさんとKanishka Raoさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Carter Moorse on Unsplash

RetinaGAN

RL-CycleGAN は「タスクレベルの物体認識」を使用して強化学習のシミュレーション環境から現実世界へ確実に転移させますが、当然の疑問が生じます。

様々なタスクやロボット学習に広く応用できる、より柔軟なシミュレーション環境から現実世界への転移テクニックを開発できるでしょうか?

ICRA 2021 で発表された論文「RetinaGAN: An Object-Aware Approach to Sim-to-Real Transfer」では、「ロボットの物体認識」に焦点を当てることにより、シミュレーションから現実への転移させる同様なGANアプローチであるRetinaGANを開発します。このアプローチは、タスクにもアルゴリズムにも依存しません。

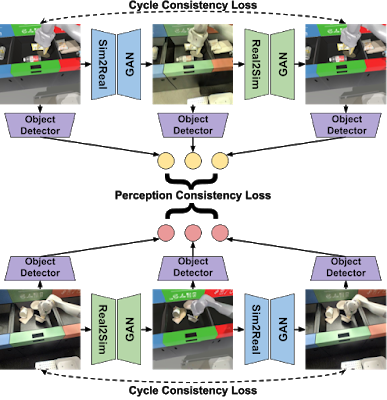

RetinaGAN は、すべての画像上のすべての物体の境界ボックス位置を予測する物体検出による知覚の一貫性を通じて、物体レベルの知覚を強制します。

理想的な「シミュレーション環境から現実世界への変換」モデルでは、変換時に物体が構造的に変化してはなりません。私達はGANを使った変換の前後で物体検出器が同じ境界ボックス位置を予測することを期待しています。RetinaGAN は、バックプロパゲーションによってこの理想に向かってトレーニングされます。

以下のa)、b)両方のケースで物体認識に一貫性があるようにする事でこれを行います。

a) シミュレートされた画像が、シミュレーションから実際の画像に変換され、その後シミュレーション画像に再変換された時

b) 実際の画像がシミュレーションに変換され、その後、実体の画像に再変換された時

この物体ベースの一貫性は、RL-CycleGAN が必要とするタスク固有の整合性よりも広く応用できることがわかりました。

RetinaGANの概要図

シミュレートされた画像(左上)は、sim-to-real ジェネレーターによって変換され、続いて real-to-sim ジェネレーターによって変換されます。

現実世界の画像(左下)は逆の順序で変換されます。シミュレートされた画像から開始する作業フローと実際の画像から開始される作業フローが個別にあると、GAN のパフォーマンスが向上します。

現実世界のロボットを使ったRetinaGAN の評価

より柔軟なsim-to-realの転移手法を構築するという目標を考えて、RetinaGAN を複数の方法で評価して、どのタスクに対してどのような条件下でsim-to-realの転移が達成できるかを理解する事にしました。

まず、RetinaGAN を物体把握タスクに適用しました。以下に視覚的に示すように、RetinaGAN は、把握可能な物体の視覚的品質と顕著性を維持しながら、現実世界の物体の質感、影、および照明の変換に重点を置きます。

事前トレーニング済みの RetinaGAN モデルと分散強化学習メソッド Q2-Opt を組み合わせて、物体把握用に視覚ベースのタスク モデルをトレーニングします。

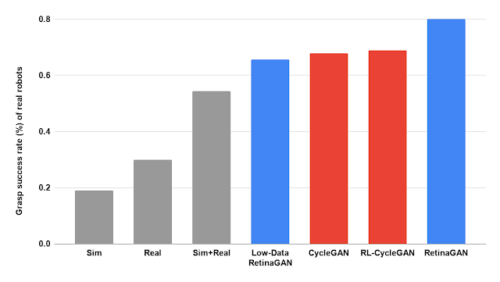

現実世界のロボットを使った訓練では、RetinaGAN のポリシーは、10万回のエピソードでトレーニングされたときに80%の成功率で物体の把握が可能です。

これは従来のsim-to-real変換手法である RL-CycleGAN および CycleGAN (両方とも68%を達成) 、及びdomain adaptationなしのトレーニング手法(下の灰色のバー: 19% がシミュレーションのみデータ、22% が現実世界データ、54% が混合データ)を上回っています。

これにより、知覚の一貫性がシミュレーションからリアルへの移行にとって価値のある戦略であるという確信が得られます。さらに、わずか 10,000 回のトレーニング エピソード(データの 8%)で、RetinaGAN を使用した強化学習ポリシーは 66%の成功率で把握し、大幅に少ないデータで従来手法と同等のパフォーマンスを達成します。

様々なデータセットとシミュレーション手法でトレーニングされた、物体の把握に関する RL ポリシーのパフォーマンス。Low-Data RetinaGANは、現実世界のデータセットの 8% を使用して訓練されています。

シミュレートション内の把握環境(左)は、RetinaGAN を通じて現実世界の画像(右)に変換されます。

次に、RetinaGAN を別の学習方法である行動複製(behavioral cloning)と組み合わせて、人間のオペレーターによるデモンストレーションに基づいて会議室のドアを開くタスクを行わせます。

シミュレート環境でのデモンストレーションと現実世界でのデモンストレーションの両方の画像を使用して、RetinaGAN をトレーニングして合成画像を現実世界の画像に見えるように変換し、sim-to-realギャップを埋めます。

それから、現実世界で行ったデモとRetinaGAN で変換したシミュレーション内で行ったデモを使って、人間のオペレーターが行ったタスク解決アクションを模倣するように、行動複製モデルをトレーニングします。

実行するアクションを予測してこのモデルを評価すると、ロボットは 93%以上の確率で現実世界の会議室に入室できました。これは、75%以下の確率である比較対象モデルを上回る性能です。

上の画像はどちらも同じシミュレーションを示していますが、RetinaGAN はシミュレートされたドアの開閉画像(左)を変換して、実際のロボット センサー データ (右) のように見せています。

RetinaGAN で訓練された行動複製ポリシーを使用して、実際のロボットが会議室のドアを正常に開く 3 つの事例

結論

本研究は、GANに対する追加の制約が、タスク固有のチューニングを必要とせずに視覚的なシミュレーションと現実のギャップにどのように対処できるかを示しています。

これらのアプローチは、より少ないデータ収集でより高い現実世界のロボットを使った際の成功率を達成します。RL-CycleGAN は、強化学習を使った一貫性損失(RL-consistency loss)を使って合成画像をリアルな画像に変換します。この損失はタスクに関連する特徴を自動的に保持します。

RetinaGAN は、タスクの学習方法に依存せず、環境の違いにもタスクの違いにも影響を受けずに堅牢に物体認識を転移する sim-to-real 変換技術です。

RetinaGAN はタスク固有の知識でトレーニングされていないため、物体を押す新規タスク(novel object pushing task)に再利用する事も出来ます。

sim-to-realギャップに関する作業が、構造化されていない環境でのタスクにとらわれないロボット操作の解決に向けてさらに一般化されることを願っています。

謝辞

RL-CycleGAN の研究は、Kanishka Rao, Chris Harris, Alex Irpan, Sergey Levine, Julian Ibarz 及び Mohi Khansariで実施されました。

RetinaGAN の研究は、Daniel Ho, Kanishka Rao, Zhuo Xu, Eric Jang, Mohi Khansari そして Yunfei Baiによって実施されました。

また、ロボットの運用を監督してくださった Ivonne Fajardo, Noah Brown, Benjamin Swanson, Christopher Paguyo, Armando Fuentes, そして Sphurti Moreに感謝します。

私達はPaul Wohlhart, Konstantinos Bousmalis, Daniel Kappler, Alexander Herzog, Anthony Brohan, Yao Lu, Chad Richards, Vincent Vanhoucke, and Mrinal Kalakrishnan, Max Braun、Google のロボティクス チームと Everyday Robot Project の他の方々に、貴重な議論と支援をいただいたことに感謝します。

3.RetinaGAN:シミュレーション環境から現実世界への転移を一般化(2/2)関連リンク

1)ai.googleblog.com

Toward Generalized Sim-to-Real Transfer for Robot Learning

2)arxiv.org

RL-CycleGAN: Reinforcement Learning Aware Simulation-To-Real

RetinaGAN: An Object-aware Approach to Sim-to-Real Transfer

3)retinagan.github.io

RetinaGAN: An Object-aware Approach to Sim-to-Real Transfer