1.MediaPipe Iris:リアルタイムに眼球の虹彩を追跡し距離を推定(2/2)まとめ

・MediaPipe Irisは特別なハードウェアを必要とせずに被写体までの距離を測定可能

・MediaPipe上で実装されているのでPC、モバイル、およびブラウザで実行可能

・今後はより安定したトラッキングでエラーを減らし、使い勝手の向上に取組予定

2.MediaPipe Irisの性能

以下、ai.googleblog.comより「MediaPipe Iris: Real-time Iris Tracking & Depth Estimation」の意訳です。元記事の投稿は2020年8月6日、Andrey VakunovさんとDmitry Lagunさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Kevin CASTEL on Unsplash

虹彩からの深度推定:単一画像から奥行情報を推定

私達の虹彩追跡モデルは、特別なハードウェアを必要とせずに、10%未満の誤差で被写体からカメラまでの距離を測定できます。

これは、人間の目の虹彩の水平径が、多岐にわたる調査結果の結果、ほぼ11.7±0.5mmの範囲に収まっているという事実から、単純な幾何学的計算によって実現できます。

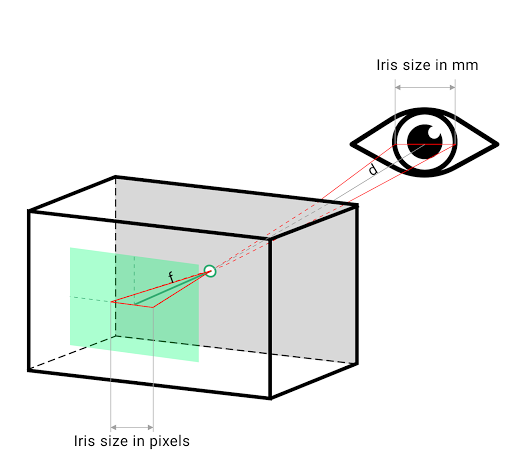

説明のために、正方形の画素センサーに投影するピンホールカメラモデルを考えましょう。被写体までの距離は、カメラの焦点距離を使用して顔の目印から推定できます。

カメラの焦点距離は、カメラキャプチャAPIを使用して取得するか、または他のカメラ固有のパラメーターと共に取得した写真のEXIFメタデータから直接取得できます。

焦点距離を考えると、被写体からカメラまでの距離は、以下に示すように、被写体の目の物理的なサイズに正比例します。

被写体の距離(d)は、三角形の相似を使用して、焦点距離(f)と虹彩サイズから計算できます。

左:深度センサーを使用せずに、Pixel 2上で虹彩追跡のみ奥行距離をcm単位で予測するMediaPipe Iris

右:真の奥行情報

この方法の精度を定量化するために、200人以上の実験参加者の正面向きの同期ビデオおよび深度画像を収集することにより、iPhone 11の深度センサーと比較しました。レーザー測距デバイスを使用して、iPhone 11の深度センサーの誤差が2メートルまでの距離で2%未満であることを実験で検証しました。

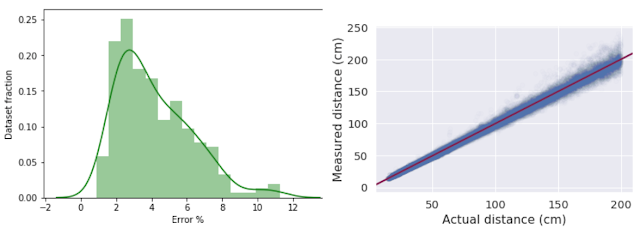

私達の評価では、虹彩サイズを使用した私達の深度推定のアプローチには、4.3%の平均相対誤差と2.4%の標準偏差があることを示されています。眼鏡をかけた状態とかけていない状態(参加者のコンタクトレンズは考慮しません)の参加者に対してアプローチをテストしたところ、眼鏡によって平均相対誤差がわずかに4.8%(標準偏差3.1%)増加することがわかりました。

眼に疾患(角膜老人環やパンヌスなど)を持つ参加者に対しては、このアプローチをテストしていません。MediaPipe Irisが特別なハードウェアを必要としないことを考慮すると、これらの結果は、安価なデバイスでも単一画像から奥行情報を取得できる可能性があることを示唆しています。

左:推定誤差のヒストグラム

右:実際の距離と虹彩による推定距離の比較

MediaPipe Irisの公開

虹彩および虹彩を使った深度推定モデルを、デスクトップ、モバイル、およびWebで実行できるクロスプラットフォームのMediaPipeパイプラインとしてリリースします。MediaPipe on the webに関する最近のGoogle Developer Blogの投稿「MediaPipe on the Web」で説明されているように、WebAssemblyとXNNPACKを利用して、データをクラウドに送信せずにブラウザでローカルにIris MLパイプラインを実行する事ができます。

MediaPipeのWASMスタックを使用して、ブラウザでローカルにモデルを実行できます。

左:虹彩の追跡

右:EXIFデータを含む写真とその虹彩から計算された奥行距離

虹彩追跡はviz.mediapipe.devのiris_trackingデモで、虹彩深度測定はiris_depthのデモで試すことができます。

今後の方向性

MediaPipe Irisモデルを拡張して、より安定したトラッキングでエラーを減らし、ユーザの使い勝手の改善などに応用する予定です。

私達は、コードを共有する事で様々な分野で再現可能な研究、迅速な実験、新しいアイデアの開発が可能になると強く信じています。

ドキュメントと付属のモデルカードでは、これらのモデルの使用がGoogleのAI原則と確実に一致するように、使用目的、制限、モデルの公平性について詳しく説明しています。どのような形の監視または識別も明示的に範囲外であり、このテクノロジーでは有効にならないことに注意してください。この虹彩知覚機能をより広い研究開発コミュニティに提供することで、創造的な使用方法が出現し、責任ある新しいアプリケーションと新しい研究手段が刺激されることを願っています。

MediaPipeのその他のMLソリューションについては、google.github.ioのsolutionsページとGoogle Developerブログで最新のアップデートをご覧ください。

謝辞

モデルの評価とデータ収集をサポートしてくれたArtsiom Ablavatski, Andrei Tkachenka, Buck Bourdon, Ivan Grishchenko 及び Gregory Karpiakに感謝します。Yury Kartynnik, Valentin Bazarevsky, Artsiom Ablavatskiはメッシュ技術を開発してくれました。Aliaksandr Shyrokauとアノテーションチームは、データの準備に努めてくれました。Vidhya Navalpakkam, Tomer Shekel, Kai Kohlhoffは専門領域の知識を提供してくれました。Fan Zhang, Esha Uboweja, Tyler Mullen, Michael Hays 及び Chuo-Ling ChangはモデルのMediaPipeへの移行を支援してくれました。本テクノロジーの開発を継続的に支援してくださったMatthias Grundmann, Florian Schroff そして Ming Guang Yongにも感謝します。

3.MediaPipe Iris:リアルタイムに眼球の虹彩を追跡し距離を推定(2/2)関連リンク

1)ai.googleblog.com

MediaPipe Iris: Real-time Iris Tracking & Depth Estimation

2)mediapipe.dev

MediaPipe

3)google.github.io

MediaPipe Face Mesh

MediaPipe Iris

4)viz.mediapipe.dev

demo/iris_tracking

コメント