1.機械学習を用いて賢い繊維を実現(3/3)まとめ

・e繊維をスクロールパッドやコントロールボタンと比較した結果、ユーザからは好反応を得た

・表現力の観点からもコード全てが操作対象となるe繊維は操作箇所を間違える事がなく操作速度も速い

・ジェスチャーを使った試作品(ヘッドフォン、衣服の引き紐、スピーカーのコード)も完成している

2.e繊維の評価

以下、ai.googleblog.comより「Enabling E-Textile Microinteractions: Gestures and Light through Helical Structures」の意訳です。元記事の投稿は2020年5月15日、Alex Olwalさんによる投稿です。

実用例としてとても興味深いお話ですが、具体的にどこで何を使って機械学習を動かして紐の動きを分類しているのかが特に書かれててなかったのでちょっと残念でした。

ハードウェアについてはおそらくまぁ、エッジコンピューティングって事なんだろうなと思ったのですが、元論文を斜め読みしたところ、ソフトウェアについてはscikit-learnとtslearnと書いてあったのでEdge TPUなども使ってなさそうでした。

アイキャッチ画像のクレジットはPhoto by K8 on Unsplash

特定のユーザーの操作に依存しない装置へ:精度と速度を定量化

ユーザー毎にトレーニングしたジェスチャー認識により、8つの新しい個別のジェスチャーが認識可能になりました。

これを恒久的な操作方法にするために、e繊維を使ったユーザーに依存しない「ねじる操作」が他の精度の高い操作方法に対してどれだけうまく機能するかを数値化したいと考えました。

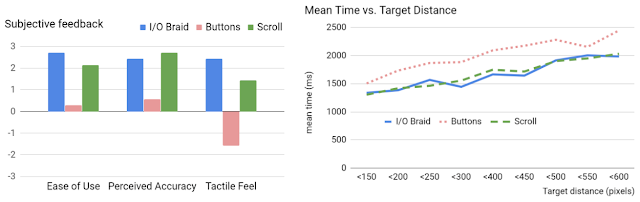

私達は、e繊維(I/O Braid)をスクロールパッド(Scroll)とおなじみのヘッドフォンのコントロールボタン(Buttons)と比較しました。

そして、3つの装置を使って対象タスクを実行する際の動きを計測する実験を設計しました。

12人の参加者に3つの装置を使って1800回の試行をしてもらいました。その結果を以下の3つの変数、「タスクの実行にかかる時間(ミリ秒)」、「動きの数」、「終了時の動きの数」、で分析しました。参加者には、主観的な感想としてコメントとランク付けも依頼しました。

私たちの定量分析は、e繊維によるねじる操作が既存のヘッドフォンコントロールボタンよりも速く、タッチパッドと同等の速度であることを示唆しています。主観的な感想は、ヘッドフォンコントロールボタンよりもe繊維を使った操作が好まれる事も示しています。

左図:主観的な感想による評価

アンケートで良く使われるリッカート尺度を7段階の-3から+3の範囲に設定し、各装置が受け取った評価と回数を掛けて、平均スコアを算出しました。

右図:装置までの距離と平均操作完了時間の関係は、ボタンによる操作が常に最も遅いことを示しています。

これらの結果は、固い表面を持つ入力デバイス(つまり従来のボタン等)と比較して、e繊維が繊細である事を考えると、特に興味深いものです。

1つの説明はその表現力かもしれません。ユーザーはコードのどこでもすばやくまたはゆっくりとねじることができ、操作は対称的で時計回りでも反時計回りでも可能です。

ヘッドフォンの従来のボタンでは、ユーザーが自分でボタンの位置を見つけて操作を行う位置を特定する必要があり、間違ったボタンを押してしまうなどの負担があります。

e繊維は偶然皮膚が接触して誤操作する事を防ぐためにハイパスフィルターを使用していますが、堅牢性を高め、実際の使用状況での長期的なパフォーマンスを評価するには、更に研究が必要です。

ジェスチャーを使った試作品(ヘッドフォン、衣服の引き紐、スピーカーのコード)

私たちは、e繊維の機能を実証するためにさまざまな試作品を開発しました。

・USB Type-Cケーブルのヘッドフォンにe繊維を使ってスマートフォンの再生機能を制御

・パーカーの引き紐(hoodie drawstring)にe繊維を使って目立たない音楽再生機能を実現

・スピーカーのコードにe繊維を使って配線を介したジェスチャーによる制御を実現

左図:タップ操作 = 再生/一時停止

中央図:ダブルタップ操作 = 次の曲

右図:ロール操作 = ボリュームを上げる/下げる

音楽の再生を連続的なジェスチャー(ツイスト/ローリング)と断続的なジェスチャー(ピンチ/パット)を同時に使って制御するインタラクティブなスピーカーとそのコード

結論と今後の方向性

埋め込まれたセンサーと光ファイバーによって、対話的に操作を行う事が出来るe繊維の設計を紹介しました。e繊維は小さくまとまった繊維を素材とする配線を実現可能で、小さい動きも大きな動きも検知する事ができます。

本研究により、繊維を使ったユーザーインターフェイスを進化させ、将来のウェアラブルなインタフェース、つまり衣服のように身に付けている素材を介した操作や、スマートファブリック(賢い布地)を用いたマイクロインタラクション(細かい操作/挙動)の採用を刺激したいと考えています。

これらの技術は、視覚に頼らずに実行出来る操作として、もしくは、気軽で簡単で効率的な操作が有益な場面で特に役立つ可能性があります。私たちのe繊維が、工業デザインと美的感覚を維持しながら規模拡大可能で物理的な物体を増強できる技術として、皆さんのアイディアを刺激することを願っています。

謝辞

本研究は、Googleの複数のチームによる共同作業です。

このプロジェクトの主要な貢献者には、Alex Olwal, Thad Starner, Jon Moeller, Greg Priest-Dorman, Ben Carroll, 及び Gowa Maininiが含まれます。Google ATAP Jacquardチーム、特にShiho Fukuhara, Munehiko Sato,Ivan Poupyrevにもご協力いただき、感謝します。Google Wearablesチーム、特にKenneth AlbanowskiとKarissa Sawyerに感謝します。最後に、イラストを提供してくれたMark Zarich、ビデオ撮影に協力してくれたBryan Allen、データ処理についてはFrank Li、貴重な討論をしてくれたMathieu Le Goc、繊維に関してのアドバイスをくれたCarolyn Priest-Dormanに感謝します。

3.機械学習を用いて賢い繊維を実現(3/3)関連リンク

1)ai.googleblog.com

Enabling E-Textile Microinteractions: Gestures and Light through Helical Structures

2)dl.acm.org

E-Textile Microinteractions

コメント