1.ML-fairness-gym:機械学習システムの長期的な影響を調査するツール(3/3)まとめ

・機会均等エージェントは公平性を担保しようとして多くの貸付を行い信用格差を拡大する側面がある

・重視する指標が「グループ間の信用格差」なのか「融資金額の合計」かに応じて判断も変わる

・各年のTPRを等しくしても合計TPRが等しくなるとは限らず機会均等性の解釈は一筋縄ではいかない

2.シンプソンのパラドックスとは?

以下、ai.googleblog.comより「ML-fairness-gym: A Tool for Exploring Long-Term Impacts of Machine Learning Systems」の意訳です。元記事の投稿は、2020年2月5日、Hansa Srinivasanさんによる投稿です。アイキャッチ画像のクレジットはPhoto by bruce mars on Unsplash

公平性とは変化しないものではありません:分析を長期視点に拡張する

Liu等による貸付問題の定式化は、銀行の融資ポリシーの短期的な結果のみを検討していました。

そのため、短期的な利益を最大化するポリシー(Max Rewardエージェント)、および機会均等制約を受けるポリシー(equality of opportunity:EOエージェント)が含まれます。ML-fairness-gymを使用して、シミュレーションを介して分析を長期(多くのステップ)に拡張します。

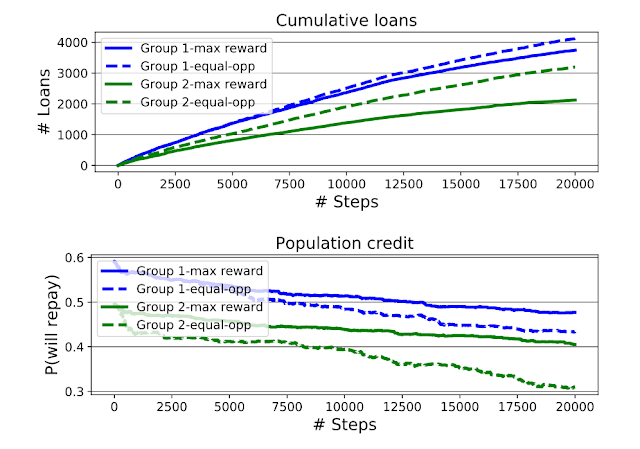

上図:ローン申請者のグループによって分類された、Max RewardエージェントおよびEOエージェントによって許可されたローンの累積金額

下図:シミュレーションが進行するにつれて各グループの平均クレジットがどのように変化するかをグラフ化したもの。平均クレジットは各グループの条件付き返済確率で定量化しています。EOエージェントは、グループ2に所属する個人のローン申請許可件数を増やしますが、グループ間の信用格差も拡大させてしまいます。

長期分析では、2つの事がわかりました。

第一に、Liu等によって見出されたように、機会均等エージェント(EOエージェント)は、不利な立場にあるグループ(当初の平均クレジットスコアが低いグループ2)に、利益最大化エージェントが使用するしきい値よりも低いしきい値を適用する事で、過剰に貸し付けを行います。

これにより、グループ2のクレジットスコアがグループ1よりも減少し、利益最大化エージェントを使用したシミュレーションよりもグループ間の信用格差が大きくなります。

しかし、グループ2はEOエージェントを使用する事で格差が悪化するように見えるかもしれませんが、累積ローン金額のグラフを見ると、不利なグループ2はEOエージェントによって、より多くのローンを許可されているがわかります。

重視する指標が「クレジットスコア」なのか「融資金額の合計」であるのかに応じて判断が変わってきます。グループ2にとってEOエージェントの方が利益最大化エージェントより優れている、もしくは有害であるといずれの主張も可能です。

第二の発見は、機会均等の制約です。

機会均等では、各ステップでグループ間でTPRが均等になるように調整します。しかし、これはシミュレーション全体でTPRを均等にしません。

このおそらく直感に反する結果は、シンプソンのパラドックスの一例と考えることができます。

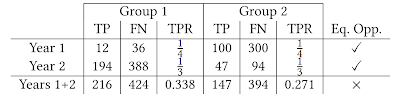

以下の表に見られるように、各TPRが2年間等しいことは、2年間の総TPRが等しいことを意味しません。

これは、基準となるグループが変化していく時、機会均等性をどのように解釈すべきかが非常に難しい問題である事を示しています。また、機械学習システムが目的の効果を発揮している事を確認するためには、より慎重な分析が必要であることを示唆しています。

シンプソンのパラドックスの例

TPは真陽性、FNは偽陰性に対応し、TPRは真陽性率です。

1年目と2年目に、銀行は2つのグループが平等なTPRになるように審査ポリシーを適用します。TPRを2年間で集計すると等しくなりません。

結論と今後の作業

本投稿では、貸出問題に関する調査結果に焦点を当てましたが、ML-fairness-gymを使用して、様々な公平性の問題に取り組むことができます。

私たちの論文は、機械学習の公平性に関する学術文献で以前に研究された他の2つのシナリオの分析を拡張します。

ML-fairness-gymフレームワークは、「公平性」が十分に検討されていない問題をシミュレートおよび調査するのに十分な柔軟性も備えています。

例えば、サポートペーパー「Fair treatment allocations in social networks」では、ソーシャルネットワーク上の個人やコミュニティ全体の公平性の概念をよりよく理解する研究を行っています。私達はこれを精密疾病管理問題(precision disease control problem)と呼び、流行制御の定型化を検討しています。

私達は機械学習アルゴリズムが私達の社会に及ぼす影響を他の研究者や機械学習開発者がよりよく理解し、より責任のある公平な機械学習システムの開発に繋がるML-fairness-gymの可能性に興奮しています。

ML-fairness-gym Githubリポジトリでコードと論文を見つけてください。

3.ML-fairness-gym:機械学習システムの長期的な影響を調査するツール(3/3)関連リンク

1)ai.googleblog.com

ML-fairness-gym: A Tool for Exploring Long-Term Impacts of Machine Learning Systems

2)github.com

google/ml-fairness-gym

fairmlforhealth2019_fair_treatment_allocations_in_social_networks.pdf

コメント