1.AdvGen:ニューラル機械翻訳を堅牢にするために敵対的サンプルを利用(2/2)まとめ

・AdvGenの出力する敵対的サンプルを利用して堅牢性の損失が計算され、モデルにフィードバックされる

・AdvGenを用いた学習によりニューラル機械翻訳は通常のベンチマークでも性能が向上した

・入力データセットに人工的なノイズを加えたテストでも他のトランスフォーマーよりスコアが改善された

2.AdvGenによる性能向上

以下、ai.googleblog.comより「Robust Neural Machine Translation」の意訳です。元記事は2019年7月29日、Yong Chengさんによる投稿です。

防御ステージでは、敵対的な文章がTransformerモデルにフィードバックされます。やはり翻訳損失が計算されますが、今回は敵対的な文章を元に計算されます。前述と同じ方法を使用して、AdvGenはターゲット入力文、単語置換候補、アテンション行列によって計算された単語選択分布、および翻訳損失を使用して、敵対的ターゲットサンプルを構築します。

防御ステージでは、敵対的サンプルがTransformerモデルへの入力として機能し、翻訳損失が計算されます。AdvGenは、ターゲット入力から敵対的ターゲットのサンプルを生成するために上記と同じ方法を使用します。

最後に、敵対的文章がTransformerにフィードバックされ、敵対的ソースサンプル、敵対的ターゲット入力サンプル、およびターゲット文を使用して堅牢性損失が計算されます。

入力文章のわずかな違いが大きな損失をもたらす場合、モデルが同様な事例に遭遇した際に同じ過ちを繰り返さないように、損失が最小限になるように調整されます。一方、損失が大きくない場合は何もせず、モデルが既にこのブレに対応できていることを示します。

モデルの性能

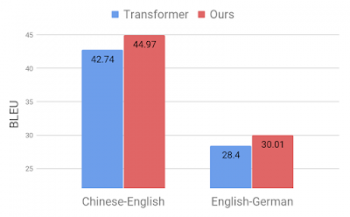

私達は、標準的な中国語 – 英語、および英語 – ドイツ語間の翻訳ベンチマークを使って、私達のアプローチの有効性を実証しました。

競合するTransformerモデルと比較して、それぞれ2.8および1.6 BLEUポイントの顕著な改善が見られ、新たに最先端のパフォーマンスが達成されました。

標準的なベンチマークを使ったTransformerモデル(Vaswani等による2017の研究)との比較。

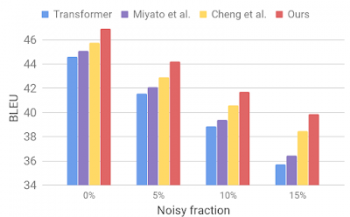

次に、AdvGenと同様な手順を使用して生成されたノイズの多いデータセットを使ってモデルを評価します。標準の翻訳ベンチマークで使用されているようなクリーンな入力データセットを使い、ランダムに選択した単語を同じ意味を持つ単語に置換え、それを入力データとして使います。以下の図では私達のモデルは他の最近のモデルと比較して堅牢性が改善されている事が示されています。

人工的なノイズを持つ入力データを翻訳した際の他のトランスフォーマー(Miyato等,Cheng等の研究)との比較

これらの結果は、私達の方法が入力文中の小さなブレを克服し、汎化性能を改善することができることを示しています。競合する翻訳モデルを凌駕し、標準ベンチマークで最先端の翻訳パフォーマンスを達成しました。

私達の翻訳モデルが、不完全な翻訳が許容できないような多くのタスクで機械翻訳の性能を改善するための堅牢な構成要素として役立つことを願っています。

謝辞

この研究は、Yong Cheng, Lu Jiang, Wolfgang Machereyによって行われました。リーダーシップを発揮してくれたAndrew MooreとJulia (Wenli) Zhuに感謝します。

3.AdvGen:ニューラル機械翻訳を堅牢にするために敵対的サンプルを利用(2/2)まとめ

1)ai.googleblog.com

Robust Neural Machine Translation

2)arxiv.org

Robust Neural Machine Translation with Doubly Adversarial Inputs

コメント