1.Pixel 3のSuper Res Zoomで更に綺麗な写真を撮影する(1/3)まとめ

・Pixel 3のズーム機能Super Res Zoomの技術の解説

・従来のデジタルズームと違い複数枚の写真から高解像度画像を作成

・ハッブル宇宙望遠鏡などで使われている技術だがスマホで実現するのは簡単ではなかった

2.Super Res Zoomとは?

以下、ai.googleblog.comより「See Better and Further with Super Res Zoom on the Pixel 3」の意訳です。中編はこちら。後編はこちら。Pixel 3関連の記事のまとめはこちら

レンズではなくアルゴリズムを使用したデジタルズームは、長い間、携帯機器のカメラの「醜いアヒルの子」でした。DSLRカメラ(デジタル一眼レフカメラ)の光学ズーム機能と比較して、デジタルズームされた画像の品質は競争力がなく、従来のやり方では、より大きなカメラの複雑な光学系および機構を、はるかに小型なモバイル機器カメラおよび巧妙なアルゴリズムで置き換えることはできませんでした。

注)光学ズームはレンズ等の機能を利用して実際に大きな倍率で写真を撮る事。デジタルズームは倍率が同じ写真をデジタル処理を加えて大きく見えるようにする事。従来のデジタルズームは強引に引き延ばしているだけなのであまり綺麗に見えないという難点がありました。

Pixel 3の新しいSuper Res Zoom機能により、私たちはその概念に挑戦しています。

Pixel 3のSuper Res Zoomテクノロジは、従来のデジタルズームの手法、つまり1つの画像を切り抜いた部分の解像度をより大きく変換する事とは異なっています。Super Res Zoomテクノロジは複数の画像を高解像度の画像に直接融合するため、従来の手法より優れているのです。

他の多くのスマートフォンが持つ2倍光学ズームレンズに匹敵するほど細部が大幅に品質が改善されます。 Super Res Zoomとは、シャッターを押す前にピンチズームをすると、シャッターを押した後に画像を切り抜くよりもはるかに細かい画像が得られるということです。

2倍ズームとの比較:2017年のPixel 2 vs 2018年のPixel 3のSuper Res Zoom

デジタルズームの課題

デジタルズームは簡単ではありません。何故なら、優れたアルゴリズムは、より低い解像度の画像を元に、元画像に欠けている詳細部分を確実に再構成することが期待されるためです。典型的なデジタルズームでは、単一の画像の小さな切り抜きが、はるかに大きな画像にスケールアップされます。伝統的に、これは元の画像に存在しない情報を再現しようとする線形補間法によって行われますが、テクスチャや細部が不足しているぼやけたプラスティック風な外観になってしまいます。

対照的に、ほとんどの最近の単一画像解像度向上アプリは機械学習(私たちの以前の研究であるRAISRを含みます)を使用します。この手法では、直線やエッジのような特定の画像特徴を拡大したり、特定のテクスチャを合成することさえできますが、自然な高解像度の詳細を復元することはできません。

私達は現在もRAISRを使用して画像の画質を向上させていますが、Super Res Zoomで提供される解像度の向上(少なくとも2~3倍程度の控えめなズームでは)は、マルチフレーム方式によるものです。

カラーフィルタ配列とデモザイク

細部の再構成は、デジタル写真が最初から不完全であるために特に困難です。部分的な色情報からデモザイキングと呼ばれるプロセスを用いて再構成されます。典型的な一般消費者向けカメラでは、カメラセンサは、光の強度のみを測定するものであり、その色を直接測定するものではありません。

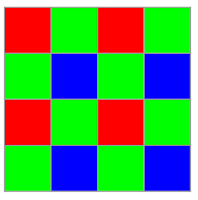

風景に存在する実際の色を取り込むために、カメラはセンサの前に配置されたカラーフィルタアレイを使用します。そのため、各ピクセルは単一の色(赤、緑、または青)のみを測定する事ができます。これらは、下の図に示すようにベイヤーパターンで配置されています。

ベイヤーモザイクカラーフィルタ(Bayer mosaic color filter)。各2×2ピクセルのグループは、特定の色でフィルタリングされた光を捕捉します。2つの緑色のピクセル(なぜなら人間の目は緑色により敏感なためです)、1つは赤色、そしてもう一つは青色です。このパターンは画像全体にわたって繰り返されます。

カメラ処理パイプラインは、この部分的な情報を考慮して、すべてのピクセルで実際の色とすべての詳細を再構成する必要があります。デモザイクは、欠落している色情報を、通常は近くのピクセルの色から補間することによって最もよく推測することから始まります。つまり、RGBデジタル画像の3分の2は実際のデータではなく再構成されたデータなのです!

デモザイク処理では、隣接する隣接ピクセルを使用して色情報を再構成します。

最も簡単な形では、これは隣接する値を平均化することで実現できます。実際のデモザイキングアルゴリズムのほとんどはこれよりも複雑ですが、部分的な情報のみに限定されているため、結果も最終的な画像も完全ではありません。

このような状況は、大型のDSLRカメラにも存在しますが、大型カメラはセンサーもレンズも大きいため、典型的なモバイルカメラより多くの詳細をキャプチャできます。

モバイルデバイスをピンチズームすると状況は更に悪化します。アルゴリズムはさらに近くのピクセルから補間を行って更に多くの情報を補うことを強いられるからです。

しかし、すべてが失われるわけではありません。バースト写真撮影と複数の画像の融合を使用すれば、モバイル機器のカメラに性能的制限があっても、超解像度が可能になります。

バースト写真からマルチフレーム超解像度まで

一枚の写真は欠けている色情報を補完するために十分ではありませんが、連続して撮影された複数の画像からなら欠落した情報を得ることができます。複数の連続した写真を取り込んで結合するプロセスは、バースト写真(burst photography)と呼ばれています。

GoogleのHDR +アルゴリズムはNexusとPixelの携帯電話でうまく活用され、複数の写真情報を使用して、携帯電話で撮った写真をより大きなセンサーを利用できる一眼レフカメラ同等の品質まで引き上げました。画像の解像度を上げるために同様のアプローチを使用できないでしょうか?

10年以上前から、わずかに異なる位置から撮影した複数の画像をキャプチャして組み合わせると、光学ズームと同等の解像度が得られるという、天文学でも「Drizzle (ハッブル宇宙望遠鏡などで使われている天文写真の解像度を上げるテクニック)」として知られている基本概念があります。これは少なくとも2倍または3倍のような低倍率且つ良好な照明条件で使用することができます。

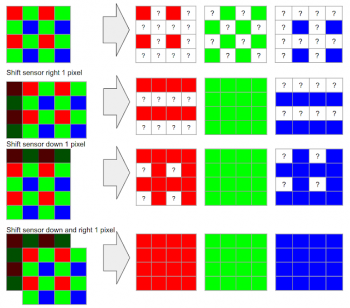

このプロセスは、マルチフレーム超解像度と呼ばれ、一般的な考え方は、低解像度のバースト(bursts)を希望するより高い解像度のグリッド上に直接整列してマージします。理想的なマルチフレーム超解像度アルゴリズムがどのように機能するか、具体的な例を以下に示します。

欠落している色(一番上の図)を補間する必要がある標準的なデモザイキングパイプラインと比較すると、理想的には、1ピクセルずつ水平方向または垂直方向にシフトした複数の画像からいくつかの欠落している情報を補完することができます。

上記の例では、4つのフレームをキャプチャしています。3つのフレームは、水平、垂直、水平および垂直の両方向に正確に1つのピクセルだけ移動しました。すべての欠落情報が補完できるので、デモザイクする必要は全くありません!実際、一部のDSLRカメラはこの操作をサポートしていますが、カメラが三脚に取り付けられていて、センサ/光学系が異なる位置で稼働している場合に限ります。これは「マイクロステッピング(microstepping)」と呼ばれることもあります。

長年にわたり、この「超解像度(super-res)」アプローチの実用的使用は、研究室、またはセンサと被写体の動きが整理され、それらの間の動きが意図的に制御されるか、厳密に制限されるような場所で使用されてきました。例えば、天文画像では、静止望遠鏡は予想通りに動く空を撮影します。

しかし、現代のスマートフォンのような広く使用されているイメージングデバイス、例えばスマートフォンのカメラのようなズームインアプリケーションなどでの超高解像度の実際の使用は、ほぼ実用化されていませんでした。

これは、部分的には、これが適切に機能するためには、特定の条件を満たす必要があるという事実によります。まず初めに、そして最も重要なことは、レンズが、使用されているセンサーよりも高性能で、詳細なディテールを映す性能を持っている必要があるということです。(逆に言えば、レンズが貧弱であればセンサーがどんなに優れていても利点が得られない事は簡単に想像できるでしょう?)この特性は、しばしばエイリアシング(aliasing)と呼ばれるデジタルカメラの望ましくない人工的特性として見られます。

イメージエイリアシング

エイリアシングは、カメラセンサーがシーン内に存在するすべてのパターンや詳細を忠実に表現することができない場合に発生します。エイリアシングの良い例はモアレ模様(干渉縞)であり、時にはテレビ番組で衣装ダンスがあまり綺麗に写らないと言う残念な結果として見られます。

さらに、物体が移動するときの物理的な特徴部分(テーブルの端など)の変化などに対してエイリアシング効果が発生します。次のバーストシーケンスでこれを観察できます。バーストシーケンス中のカメラのわずかな動きがエイリアスエフェクトを発生させます。

左:テーブルエッジの高解像度単一画像で背景が高周波パターン化されている。右:バーストからの異なるフレーム。エイリアシングエフェクトとモアレエフェクトが異なるフレーム間で表示されています。ピクセルが飛び回り、異なる色のパターンを生成しています。

しかし、このエイリアスエフェクト振る舞いは、酷いトラブルに見えますが実はありがたいものです。生成されたパターンを分析すると、前のセクションで説明したように、さまざまな色と輝度の値が与えられており、超解像度を実現できます。つまりこれは、実用的な超解像度をスマートフォンや任意のバーストシーケンスで動作させるためには、まだ多くの課題が残っているという事です。

(中編に続きます)

3.Pixel 3のSuper Res Zoomで更に綺麗な写真を撮影する(1/3)関連リンク

1)ai.googleblog.com

See Better and Further with Super Res Zoom on the Pixel 3

コメント