1.CoVeR:画像と動画で協調学習を行い行動認識を改善(2/2)まとめ

・CoVeRで学習したモデルは追加微調整を行う事なく複数のデータセットに直接適用可能

・複数のデータセットで協調学習したCoVeRは標準的な手法よりも良い結果を出す事ができた

・単一の汎用映像理解モデルを学習する事で複数のデータセットで良い性能を達成する事も可能

2.CoVeRの性能

以下、ai.googleblog.comより「Co-training Transformer with Videos and Images Improves Action Recognition」の意訳です。元記事は2022年3月1日、Bowen ZhangさんとJiahui Yuさんによる投稿です。

たアイキャッチ画像のクレジットはPhoto by Sam Manns on Unsplash

ベンチマーク結果

Kinetics-400 (K400)、Kinetics-600 (K600)、Kinetics-700 (K700)、SomethingSomething-V2 (SSv2)、 Moments-in-Time (MiT) データセットでCoVeRを評価しました。

CoVeRは、TimeSFormer, Video SwinTransformer, TokenLearner, ViViT, MoViNet, VATT, VidTr, OmniSourceといった他のアプローチと比較し、複数のデータセットにおいて新たな最先端のスコアを達成しました(下図)。

1つのデータセットに対して専用のモデルを学習させる従来のアプローチとは異なり、CoVeRで学習したモデルは、追加の微調整を行うことなく、複数のデータセットに直接適用することができます。

| Model | Pretrain | Finetune | K400 Accuracy |

| VATT | AudioSet+Videos | K400 | 82.1 |

| Omnisource | IG-Kinetics-65M | K400 | 83.6 |

| ViViT | JFT-300M | K400 | 85.4 |

| Video SwinTrans | ImageNet21K+external | K400 | 86.8 |

| CoVeR | JFT-3B | K400+SSv2+MiT+ImNet | 87.2 |

Kinetics-400 (K400)データセットでの精度の比較

| Model | Pretrain | Finetune | SSv2 Accuracy |

| TimeSFormer | ImageNet21k | SSv2 | 62.4 |

| VidTr | ImageNet21k | SSv2 | 63 |

| ViViT | ImageNet21k | SSv2 | 65.9 |

| Video SwinTrans | ImageNet21K+external | SSv2 | 69.6 |

| CoVeR | JFT-3B | K400+SSv2+MiT+ImNet | 70.9 |

SomethingSomething-V2 (SSv2)データセットでの精度比較

| Model | Pretrain | Finetune | MiT Accuracy |

| ViViT | ImageNet21k | MiT | 38.5 |

| VidTr | ImageNet21k | SSv2 | 41.1 |

| CoVeR | JFT-3B | K400+SSv2+MiT+ImNet | 46.1 |

Moments-in-Time(MiT)データセットでの精度比較

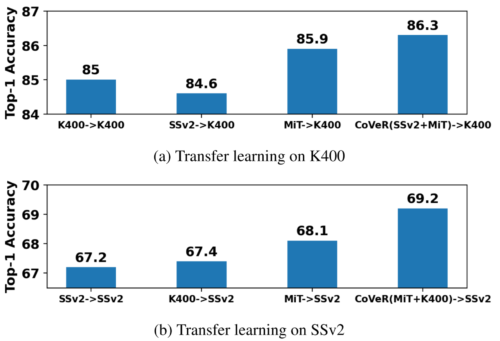

転移学習

動画における行動認識性能をさらに検証するために、転移学習を用い、複数のデータセットで協調学習(co-training)した際の結果を以下にまとめます。具体的には、元データセットで学習した後、目標とするデータセットで微調整を行い、評価しました。

まず、元データセットとしてK400を考えます。SSv2とMiTで協調学習したCoVeRは、K400→K400(K400で学習し、K400で微調整)に対してトップ1精度を1.3%、SSv2→K400で1.7%、MiT→K400で0.4%向上させることができました。

同様に、SSv2に転移することで、CoVeRはSSv2→SSv2、K400→SSv2、MiT→SSv2に対してそれぞれ2%、1.8%、1.1%の改善を達成することが確認できました。K400とSSv2に対する1.2%と2%の性能向上は、複数のデータセットで協調学習したCoVeRが標準的な学習パラダイムよりも優れた視覚特徴表現を学習できたことを示しており、この改善結果は下流タスクに有用です。

CoVeRで学習した特徴表現の転移学習と標準的な学習パラダイムの比較

A→Bは、データセットAでモデルを学習し、データセットBで微調整を行うことを意味します

まとめ

本研究では、汎用的な行動認識(action recognition)フレームワークの構築を目的として、行動認識と物体認識のタスクを単一のモデルで共同学習する学習パラダイムであるCoVeRを発表しました。

その結果、多くの動画データセットを1つのマルチタスク学習パラダイムに統合することが有効であることを示しました。また、堅牢な空間特徴表現を維持するために、微調整中も画像データで学習を継続することの重要性を強調しました。

私達の実証的知見は、CoVeRで単一の汎用映像理解モデルを学習することで、多くの行動認識データセットにわたって素晴らしい性能を達成することができる事を示唆しています。下流のアプリケーションごとに微調整を追加実施する必要はありません。、

謝辞

CoVeRの論文作成にご協力いただいたChristopher Fifty, Wei Han, Andrew M. Dai, Ruoming Pang, そしてFei Sha、有益な議論とフィードバックをいただいたYue Zhao, Hexiang Hu, Zirui Wang, Zitian Chen, Qingqing Huang, Claire Cui そして Yonghui Wu、その他、本プロジェクトを通じてご支援いただいたBrain Teamの皆様に感謝します。

3.CoVeR:画像と動画で協調学習を行い行動認識を改善(2/2)関連リンク

1)ai.googleblog.com

Co-training Transformer with Videos and Images Improves Action Recognition

2)arxiv.org

Co-training Transformer with Videos and Images Improves Action Recognition