1.HOD:あなたの医用画像分類器は、何を知らないかを知っていますか?(2/2)まとめ

・医療用MLモデルは誤診を避けるため特定の症例を知らないという事実を識別できる事が重要

・そのため分類できないOODデータを検出することは、安全性を向上させる重要なステップ

・階層的外れ値検出損失を開発し、多様なアンサンブルと組み合わせる事で信頼性を向上した

2.多様なアンサンブル戦略

以下、ai.googleblog.comより「Does Your Medical Image Classifier Know What It Doesn’t Know?」の意訳です。元記事は2022年1月27日、Abhijit Guha RoyさんとJie Renさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Piotr Musioł on Unsplash

階層的外れ値検出損失

私たちは、学習時に「既知の外れ値(known outlier)」サンプルを使用し、テスト時に「未知の外れ値(unknown outlier)」サンプルの検出を支援することを提案します。

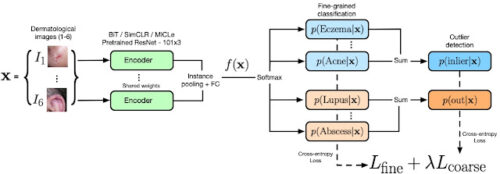

私たちの新しい階層的外れ値検出(HOD:Hierarchical Outlier Detection)損失は、すべての外れ値または通常値のクラスに対して、個々のクラスをきめ細かい粒度で分類(fine-grained)し、並行して、階層的設定において粗い粒度(coarse-grained)で通常値対外れ値の二分類を行います。(下図を参照)

粗い粒度で分類した後にきめ細かい分類を行うと、きめ細かい分類器の性能に影響を与えるボトルネックとなる可能性があるため、HODは粗い粒度で分類した後にきめ細かい粒度で分類を行うよりも有効であることが実験で確認されました。

私たちは外れ値クラスの予測確率の合計をOODスコアとして使用します。OOD検出の主要な指標として、AUROC(area under receiver operating characteristics)カーブを用います。AUROCは0から1の間の値を取り、通常値(inliers)と外れ値(outliers)を分離する性能の指標をとなります。全ての通常値と外れ値を分離できる完全なOOD検出器にはAUROCスコア1が割り当てられます。

リジェクトバケット(reject bucket)と呼ばれる人気のある従来手法は、各通常値を外れ値から個別に分離します。外れ値は専用の棄権クラス(abstention class)にグループ化されます。

それに対して、HOD損失ベースのアプローチは、個々の通常値と外れ値のクラスに対するきめ細かい分類に加えて、通常値を外れ値から粗い粒度の予測損失で一括して分離し、より良い汎化効果をもたらします。

両手法は似ていますが、HOD損失ベースの手法は、学習時に外れ値データを活用する他の比較対象手法を凌駕し、ベンチマークにおいて79.4%のAUROCスコアを達成しました。reject bucketの75.6%を大幅に上回っています。

私たちのモデル・アーキテクチャとHOD損失

エンコーダ(緑)は、異なる特徴表現学習モデル(ImageNet、BiT、SimCLR、MICLe)で事前学習したResNet 101×3のワイドモデルです。エンコーダの出力はHOD損失に送られ、通常値(青)と外れ値(オレンジ)に対するきめ細い粒度と粗い粒度の予測値が得られます。粗い予測値は、図に示されるように、細かい粒度の確率を合計することで得られます。OODスコアは外れ値クラスの確率の総和として定義されます。

特徴表現学習と多様なアンサンブル戦略

また、ImageNet、BiT-L、SimCLR、MICLeのモデルで事前学習を行い、HODと組み合わせて異なるタイプの特徴表現学習がOOD検出にどのように役立つかを調査しました。HOD損失を含めると、4つの特徴表現学習法すべてにおいて、reject bucketよりもOODの性能が向上することが確認されました。

| Representation Learning Methods | ||

| With reject bucket | With HOD loss | |

| ImageNet | 75% | 77% |

| BiT-L | 76% | 79% |

| SimCLR | 75% | 77% |

| MICLe | 77% | 79% |

reject buckeを用いた場合とHOD損失を用いた場合の異なる特徴表現学習モデルにおけるOOD検出性能

OODの検出性能と精度を向上させるためのもう一つの直交するアプローチは、独立して学習した複数のモデルからの出力を集約して最終的な予測を行うディープ・アンサンブル手法です。

私たちはディープアンサンブルをベースに、アーキテクチャと事前学習を固定するのではなく、異なる特徴表現学習アーキテクチャ(ImageNet、BiT-L、SimCLR、MICLe)を組み合わせ、目的損失関数(HODとリジェクトバケット)を導入しています。これを多様なアンサンブル戦略(diverse ensemble strategy)と呼び、OOD性能と通常値の精度でディープアンサンブルを上回ることを実証しています。

下流工程での臨床信頼性分析

OOD検出の性能向上を主な目的としていますが、皮膚分類モデルの最終的な目標は、通常状態と外れ状態を予測する精度を向上することです。

私たちは従来の性能指標以上のものを測るめ、「ペナルティ(penalty)」行列を導入します。これは、下流タスクへの影響を近似するための行列です。通常状態と外れ状態の予測を同時に評価します。

一定の信頼性閾値に対して、以下の種類のミスをカウントします。

(i)不正確な通常状態予測(通常状態Aを通常状態Bと間違えるなど)

(ii)誤って通常状態を棄権する(すなわち、通常状態の予測を外れ値と間違って棄権すること)

(iii)外れ値を誤って通常状態の1つとして予測する

それぞれの結果が同じ影響を及ぼすわけでないので、ペナルティは0、0.5、または1です。

不正確な通常値や外れ値を通常値として間違った予測は、ユーザーのモデルに対する信頼を損なう可能性があるため、1点のペナルティが課されます。

通常値を外れ値と間違えて棄権する事は、0.5のスコアで罰せられます。モデルが提示する不確実性や棄権した事を考えると、モデルの利用者は追加の助言を求めるべきであるためです。

正しい判断にはコストがかからないので、ペナルティスコアは0となります。

| モデルの行動 | ||

| 通常値として予測 | 外れ値として棄権 | |

| 通常値 | 0 (正しいクラスとして予測した場合) 1 (誤ったクラスとして予測した場合。モデルに対する信頼を傷つける可能性があります) |

0.5 (通常値を誤って外れ値として予測して棄権した場合) |

| 外れ値 | 1 (通常値として予測した場合。モデルに対する信頼を傷つける可能性があります) | 0 (正しく外れ値として予測した場合) |

ペナルティ行列は、さまざまな種類のモデル誤差の潜在的な影響を捕らえるために設計されています。

現実のシナリオはより複雑で、様々な未知の変数を含みます。ここで使用する数値は、異常値検出モデルがユーザーの信頼に与える下流タスクでの影響(これを「コスト」と呼びます)を定性的に概算できるように簡略化したものです。

このペナルティ行列を用いて、テストセットにおける下流のコストを推定し、私たちの手法をベースラインと比較する事ができます。これにより、現実世界のシナリオにおける本手法の有効性をより強く主張することができます。

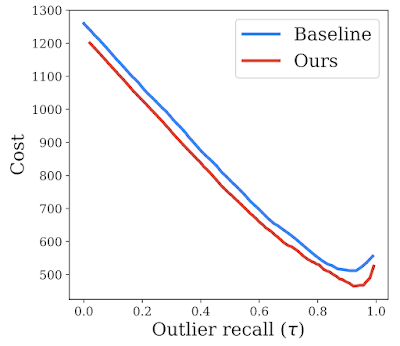

以下の図に示すように、私たちの提案する方法は、すべての取り得る値に関して、比較対象手法より低い推定コストとなります。

𝛕で示される外れ値再現率の範囲において、提案手法と比較対象手法(reject bucket)を比較した信頼性解析結果。本手法は下流の推定コストを削減し、下流への影響を改善する可能性があることを示しています。

まとめ

現実世界に展開すると、医療用MLモデルは訓練時に見る事がなかった状態に遭遇することがあり、特定の状態を知らないという事を正確に識別することが重要です。

それらの分類外(OOD:out-of-distribution)入力を検出することは、安全性を向上させるための重要なステップです。

私たちは、トレーニング時に外れ値データを活用する階層的外れ値検出損失(HOD:Hierarchical Outlier Detection loss)を開発し、それを事前にトレーニングした特徴表現学習モデルと組み合わせて多様なアンサンブルとする事でさらに性能を高め、新しい皮膚科ベンチマークデータセットにおいて比較対象手法を大幅に上回る性能を達成しました。

私たちは、AI原則に沿ったこのアプローチにより、MLアルゴリズムを実世界のシナリオにうまく適合させることができると考えています。主に皮膚科学のOOD検出に焦点を当てましたが、私たちの貢献のほとんどはかなり汎用的であり、他のアプリケーションのOOD検出に容易に組み込むことができます。

謝辞

Shekoofeh Azizi, Aaron Loh, Vivek Natarajan, Basil Mustafa, Nick Pawlowski, Jan Freyberg, Yuan Liu, Zach Beaver, Nam Vo, Peggy Bui, Samantha Winter, Patricia MacWilliams, Greg S. Corrado, Umesh Telang, Yun Liu, Taylan Cemgil, Alan Karthikesalingam, Balaji Lakshminarayanan, 及び Jim Winkensに謝辞を述べたく思います。その貢献は計り知れないものがあります。また、本投稿用にアニメーションを作成したTom Smallに感謝します。

3.HOD:あなたの医用画像分類器は、何を知らないかを知っていますか?(2/2)関連リンク

1)ai.googleblog.com

Does Your Medical Image Classifier Know What It Doesn’t Know?

2)arxiv.org

Does Your Dermatology Classifier Know What It Doesn’t Know? Detecting the Long-Tail of Unseen Conditions