1.幅広い内容の質問に長文で回答可能な質問回答システムの進歩と課題(1/2)まとめ

・事実に基づく質問回答タスクに比べると長文形式の質問回答タスクの研究は非常に少ない

・長文形式の質問回答をRouting Transformerと検索ベースのモデルを使って改良した

・これにより最先端のスコアを実現したが新たな課題が見えてきたので緩和戦略を提案

2.Routing Transformerとは?

以下、ai.googleblog.comより「Progress and Challenges in Long-Form Open-Domain Question Answering」の意訳です。元記事の投稿は2021年3月23日、Aurko Royさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Camylla Battani on Unsplash

オープンドメイン(訳注:分野を固定せず広く様々な分野を幅広く扱える事)の長文形式質問回答(LFQA:Long-Form Question Answering)は、自然言語処理(NLP:Natural Language Processing)の基本的な課題であり、質問に関連するドキュメントを取得し、それらを使用して段落レベルの長さの複雑な回答を生成します。

factoid型質問回答(訳注:数値などの事実に基づいて質問に回答するタスク)は最近目覚ましい進歩を遂げており、短いフレーズまたは実体を指して質問に回答できますが、長文形式の質問回答分野で行われている研究ははるかに少なくなっています。

それにもかかわらず、LFQAは重要なタスクです。特に、テキスト生成モデルが生成した文章の事実性を測定するための実証基盤を提供するためです。しかし、現在のベンチマークと評価指標は、LFQAを進歩させるのに本当に適しているでしょうか?

NAACL 2021に掲載予定の論文「Hurdles to Progress in Long-form Question Answering」では、NLPの最近の2つの進歩を活用した、オープンドメインの長文形式の質問回答のための新しいシステムを紹介します。

(1)ルーティングトランスフォーマー(RT:Routing Transformer)などの最先端のスパースアテンションモデル。これにより、アテンションベースのモデルを長いシーケンスにスケーリングできます。

(2)REALMなどの検索ベースのモデル(retrieval-based models)。特定の問い合わせ(クエリ)に関連するウィキペディアの記事検索を容易にします。

より事実に基づくようにするために、私達のシステムは、回答を生成する前に、特定の質問に関連するいくつかのウィキペディアの記事から取得した情報を組み合わせます。

これにより、ELI5ベンチマークで最先端のスコアを実現しました。ELI5は、長文形式の質問回答用に公開されている唯一の大規模なデータセットです。

ただし、私達のシステムは公開ランキングのトップに位置していますが、ELI5データセットとそれに関連する評価指標にはいくつかの厄介な傾向があります。 特に、

(1)モデルが条件付けられた検索を実際に使用しているという証拠はほとんどありません

(2)非常に簡単な実装(入力文の単純コピーなど)が、RAG/BART+DPRなどの最新のシステムを打ち負かしている事

(3)質問回答用の長文データセット内のトレーニング用データセット/検証用データセットに明らかな重複がある事

私達の論文は、これらの問題のそれぞれに対する緩和戦略を提案しています。

テキスト生成

NLPモデルの主な大きな貢献者は、Transformerアーキテクチャです。

Transformerでは連続データ内の各トークンは、連続データ内の他のすべてのトークンに対応します。そのため、連続データ内の長さで2次関数的に規模が拡大するモデルになります。

RTモデルは、動的なコンテンツベースのスパースアテンションメカニズムを導入し、Transformerモデルのアテンションの複雑さを\(n^2\)から\(n^{1.5}\)に減らします。nは連続データ内の長さであり、これにより長い連続データ用に規模を拡大できるようになります。

そして、近くにある単語同士しか対応できないTransformer-XLなどの方法とは異なり、各単語はテキスト全体のどこにでも他の関連する単語に対応できます。

RTで用いられる重要な洞察は、他の全てのトークンに対応する各トークンは冗長であることが多く、局所的なAttentionと大域的なAttentionの組み合わせによって概算できる可能性があるということです。

局所的なAttentionにより、各トークンはモデルの複数のレイヤーにわたって局所的な特徴表現を構築できます。各トークンは局所的な近隣(neighborhood)に参加し、局所的な一貫性と流暢さを促進します。

局所的なAttentionを補完するために、RTモデルはミニバッチk-meansクラスタリングも使用して、各トークンが最も関連性の高いトークンのセットにのみ参加できるようにします。

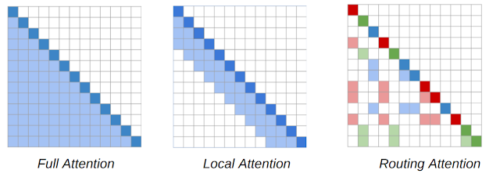

Routing Transformerで使用されるコンテンツベースのスパースアテンションメカニズムのアテンションマップ。

単語の並びは、斜めの濃い色の正方形で表されます。Transformerモデル(左図)では、各トークンは他のすべてのトークンに対応します。影付きの四角は、特定のトークン(暗い四角)が参加している単語の並びのトークンを表します。RTモデルは、トークンが局所的な近隣の他のトークンにのみ参加する局所的なAttention(中央)と、トークンが文脈内で最も関連性の高いトークンのクラスターにのみ参加するRouting Attention(右)の両方を使用します。濃い赤、緑、青のトークンは、明るい色のトークンの対応する色にのみ対応します。

言語モデリングの目的で、Project Gutenberg(PG-19)データセットのRTモデルを事前トレーニングします。例えば、モデルは、流暢な段落レベルの長いテキストを生成できるように、前段の全ての単語を指定された際に次に来る単語を予測することを学習します。

3.幅広い内容の質問に長文で回答可能な質問回答システムの進歩と課題(1/2)関連リンク

1)ai.googleblog.com

Progress and Challenges in Long-Form Open-Domain Question Answering

2)arxiv.org

Hurdles to Progress in Long-form Question Answering