1.視覚タスクで学習した重みをロボット操作タスクに転移学習する試み(3/3)まとめ

・把握ロボットではヘッドとバックボーンの両方を転送した方がバックボーン部のみより成功率が高い

・物体の位置を認識する必要がない画像分類タスクなどの重みはパフォーマンスがあまり向上しない

・物体の位置関係の認識を必要とするCOCOデータセットなどの視覚タスクの重みでは大幅に改善できた

2.有効な転移学習と有効ではない転移学習

以下、ai.googleblog.comより「Visual Transfer Learning for Robotic Manipulation」の意訳です。元記事の投稿は2020年3月20日、Yen-Chen LinさんとAndy Zengさんの投稿です。

転移学習により物体位置の認識を改善

把握ロボットを使用した実験では、事前トレーニング済みの視覚モデルのヘッドとバックボーンの両方のネットワークの重みをアフォーダンスモデルに転送した方が、バックボーン部のみを転送するよりはるかに成功率を高める事がわかりました。

| 事前学習につかったモデル名 | Random | ImageNet | COCO-backbone | COCO |

| 50回の試行で成功した割合 | 9 | 11 | 15 | 23 |

50回の試行のうち、成功した把握回数の比較

Random(ランダムに重みを初期化)

ImageNet(ImageNetで事前トレーニングしたバックボーンとヘッド)

COCO-backbone(COCOデータセットで事前トレーニングしたバックボーンのみ)

COCO(COCOデータセットで事前トレーニングしたバックボーンとヘッド)

この結果は、画像内での物体の位置関係(object localization)の認識を必要とする視覚タスク(COCOデータセットなどのインスタンスセグメンテーションなど)からネットワークの重みを再利用すると、操作タスクを学習するときに探索プロセスを大幅に改善できる可能性があることを示唆しています。

これらのタスクから事前トレーニングされた重みを転移学習する事により、ロボットは物体のように見えるものに対してアクションを試し、システムはより良い把握位置と悪い把握位置の違いをすばやく学習できます。

対照的に、画像内の物体の位置を認識する必要がない、つまり空間情報を破棄する可能性がある視覚タスク(ImageNetの画像分類タスクなど)から事前トレーニングされた重みは、ランダムな初期化と比較してパフォーマンスをわずかに向上させるだけです。

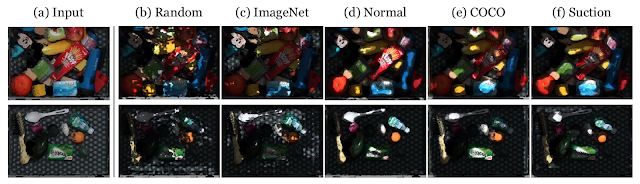

この現象をよりよく理解するために、様々な事前トレーニング済みモデルと、吸引グリッパーを使用して事前トレーニングなしでトレーニングして収束させたアフォーダンスモデルで、ニューラルネットワークの活性化状況を視覚化しました。

興味深いことに、COCOデータセットを使って画素レベルで物体を認識するように学習した視覚モデルのヘッドから学習した中間ネットワーク表現が、収束したアフォーダンスモデルと相似した活性化をする事がわかりました。

これは、可能な限り多くの視覚モデル(バックボーンとヘッドの両方)を転移すると、より物体の存在を意識した行動に繋がるという考えに沿っています。転移学習によって、視覚的特徴表現の取得と物体の位置特定に優れたモデルの重みを活用する事が出来るためです。

(a)モデルへの入力に使われる乱雑に物体が散らばっている画像。この画像内のアフォーダンスを予測します

(b)Random とは、(事前訓練を行わず)ランダムに初期化した状態から学習したモデルです

(c)ImageNetは、ImageNetで事前トレーニングされたバックボーンとランダムに初期化されたヘッドを使ったモデルです

(d)Normalとは、重力に垂直に取った軸に接する表面(surface normals)を持つ画素を検出するように事前トレーニングされたモデルを指します

(e)COCOは、COCOデータセットでトレーニングされたMaskRCNNです。

(f)Suctionは、吸引グリッパーを使用したロボットと環境の相互作用から学習した収束モデルです。

制限と将来の作業

エンドツーエンドのロボットタスクに現在使用されている学習手法の多くは、視覚タスクに使用されている手法と実質的に同じです。

視覚タスクの事前トレーニングに関する本研究は、この関係を明らかにし、視覚タスクの事前トレーニングを活用して、ロボットの操作タスク、つまりアフォーダンスベースの操作タスクの学習効率を向上できることを示しています。

今回の私達の実験はロボット分野におけるディープラーニングの理解を深めましたが、まだ調査されていない興味深い質問が沢山あります。

例えば、

・どのようにすれば他のセンサー(トルク力(force-torque)センサーや触覚センサーなど)に大規模な事前トレーニングを活用できますか?

・これらの事前トレーニング手法を、目標物体が把握タスクのように明確化されていない可能性を持つ複雑な操作タスクに拡張するにはどうすればよいですか?

これらは、将来の研究対象として有望な領域です。

この研究の詳細については、以下の要約ビデオをご覧ください。

謝辞

この研究は、Yen-Chen Lin(MITのPh.D. student)、Andy Zeng、Shuran Song、Phillip Isola(MITの教員)およびTsung-Yi Linによって行われました。特に貴重な情報を提供してくれたJohnny Leeとマネージメントの支援をしてくれたIvan Krasinに感謝します。執筆に関する有益なフィードバックについてはChad Richards、技術的な議論についてはJonathan Thompsonに感謝します。

3.視覚タスクで学習した重みをロボット操作タスクに転移学習する試み(3/3)関連タスク

1)ai.googleblog.com

Visual Transfer Learning for Robotic Manipulation

2)yenchenlin.me

Learning to See before Learning to Act: Visual Pre-training for Manipulation

コメント