1.ディープニューラルネットワークにおける一般化ギャップの予測(1/2)まとめ

・トレーニング時に出てこなかった初見のデータに対応する能力を一般化と言う

・一般化ギャップとは「トレーニングデータ」と「初見データ」に対するパフォーマンスのギャップ

・サポートベクターマシンなどで使われるマージンの概念で一般化ギャップを予測する研究が発表

2.マージンと一般化の関係

以下、ai.googleblog.comより「Predicting the Generalization Gap in Deep Neural Networks」の意訳です。元記事は2019年7月9日、Yiding Jiangさんによる投稿です。

訳注:サポートベクターマシンと言うと、ディープラーニングどっぷりの人でしたら「知らない」とか「参考書で読んだ事がある」で、scikit-learn現役バリバリの人でしたら「今も良く使う」とか、何を専門にしているのかによって印象が異なると思うのですが、今回「shallow models(浅いモデル)」と言う英語で表記されてました。おそらく、ディープラーニングを「deep models(深いモデル)」と読んでの対比なのだと思います。初期のニューラルネットワークが「できない事が多すぎでダメじゃん」となった後にサポートベクターマシンなどのニューラルネットワークを使っていない機械学習手法が全盛期になって、その後、ディープニューラルネットワークが出てきて「ディープラーニングって最強!」って現在に至っているわけですが、ディープ前のサポートベクターマシンで研究されていた手法をディープラーニングに応用したお話です。

ディープニューラルネットワーク(DNN)は、機械学習における最近の進歩の礎石であり、画像認識、画像セグメンテーション、機械翻訳などのさまざまなタスクにおける飛躍的進歩の推進力となっています。

しかし、これほどまでに身近になったにも関わらずDNNの動作原理はわかっていない事も多く、研究者たちはDNNが従っている根本的な原理原則を完全に理解しようとしています。

特に、「トレーニング時に出てこなかった未見のデータ」に対応する能力である「一般化(generalize)」は研究が盛んな分野です。

古典的理論(例えば、VC-dimensionやRademacher complexity)は、過度にパラメータ化された関数は一般化能力が乏しくなることを示唆しています。しかし、最近の研究「UNDERSTANDING DEEP LEARNING REQUIRES RETHINKING GENERALIZATION」では、過度にパラメータ化された関数(データポイントの数より数桁パラメータの数が多い)も一般化能力を持つ事を発見されました。

DNNモデルを改善するためには、一般化についてより理論的で根拠のある理解が必要で、これはDNNモデル設計のより原則的なアプローチにつながる可能性があります。

一般化を理解するための重要な概念は、一般化ギャップ、つまりモデルの「トレーニングデータ」に対するパフォーマンスと、同じ分布から得られる「トレーニング時には出てこなかったデータ」に対するパフォーマンスの違いです。

より良いDNN一般化境界(一般化ギャップの上限)を導き出す大きな進歩がありましたが、それでも実際の一般化ギャップを大きく過大評価する傾向があり、一部のモデルが非常に上手く一般化できている理由の説明がつきません。

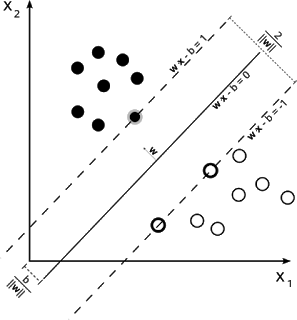

一方、マージンの概念、つまりデータポイントと決定境界との間の距離は、サポートベクターマシンのようなディープラーニングではない機械学習モデルで広く研究されてきました。そして、マージンはモデルが未見データに対して一般化出来ている度合いと密接に関係する事がわかっています。

その後、一般化パフォーマンスを研究するためにマージンを利用するアイディアがDNNモデルに拡張され、一般化ギャップの理論的な上限は非常に洗練されたものになりました。しかし、モデルの一般化の程度を予測する能力は、それほど大幅に向上しませんでした。

サポートベクターマシンの決定境界の例

W x X – b = 0 によって定義される超平面は、この線形分類器の「決定境界」です。

つまり、超平面上に存在する全ての点xは、この分類器によってどのように分類されるかわかりません。

ICLR 2019で発表した論文、「Predicting the Generalization Gap in Deep Networks with Margin Distributions」では、一般化ギャップを予測するために、ネットワーク層全体にわたる正規化したマージン分布の使用を提案しています。

3.ディープニューラルネットワークにおける一般化ギャップの予測(1/2)関連リンク

1)ai.googleblog.com

Predicting the Generalization Gap in Deep Neural Networks

2)arxiv.org

Understanding deep learning requires rethinking generalization

3)openreview.net

Predicting the Generalization Gap in Deep Networks with Margin Distributions

コメント