1.FormNet:書式に基づいた文書理解を実現(1/2)まとめ

・フォームベース(Form-based)の文書理解は実用的な可能性を持つため研究が盛ん

・従来はフォーム文書を一列に直列化してから順次処理していたが書式構造を無視していた

・FormNetは構造考慮型シーケンスモデルで最適でない順番で文書を読みこむ事を低減する

2.FormNetとは?

以下、ai.googleblog.comより「FormNet: Beyond Sequential Modeling for Form-Based Document Understanding」の意訳です。元記事は2022年4月20日、Chen-Yu LeeさんとChun-Liang Liさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Kelly Sikkema on Unsplash

フォームベース(Form-based)のドキュメント理解は、非構造化テキストデータを構造化情報に自動変換し、ドキュメントの内容に関する洞察を得るための実用的な可能性を持つため、研究テーマが拡大しています。最近のシーケンスモデリング(sequence modeling)は、選択されたテキスト内の全単語間の関係を直接モデル化するself-attention機構であり、自然言語タスクにおいて最先端の性能を実証しています。

フォーム文書理解タスクを扱うための自然なアプローチは、まずフォーム文書を一列に並べて直列化し(通常は左から右、上から下の順で)、それに最先端のシーケンスモデルを適用することです。

しかし、帳票類は、表、列、テキストブロックなどの構造化された物体を含む、より複雑なレイアウトを持つことが多いです。これらの多様なレイアウトパターンは直列化を困難にし、厳密に直列化する手法の性能を大幅に制限しています。このようなフォーム文書の構造モデリングにおけるユニークな課題は、文献上ではほとんど研究されていません。

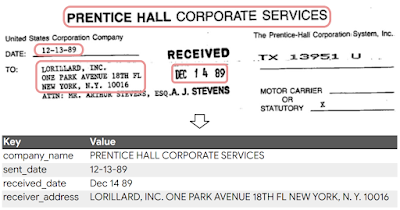

FUNSDデータセットを用いたフォーム文書情報抽出タスクの説明図

ACL 2022で発表した論文「FormNet: Structural Encoding Beyond Sequential Modeling in Form Document Information Extraction」では、FormNetと呼ぶ構造考慮型シーケンスモデルを提案します。FormNetは文書情報抽出の際にフォームから最適でない順番で文書を直列化してしまう事を緩和します。

まず、単語トークン間の2次元空間関係を利用して、より正確なAttentionの重みを計算するRich Attention(RichAtt)機構を設計します。

次に、各単語に対して、グラフ畳み込みネットワーク(GCN:Graph Convolutional Network)を用いて隣接するトークンから特徴表現を埋め込み、スーパートークン(隣接するトークンから意味的に意味を持つ情報を集約したトークン)を構築します。

最後に、FormNetがより少ない事前学習データで既存の手法を上回り、CORD、FUNSD、Paymentベンチマークで最先端の性能を達成することを示します。

情報抽出のためのFormNet

フォーム文書が与えられたら、まず BERT-multilingual vocabulary と光学式文字認識(OCR:Optical Character Recognition)エンジンを使って単語を識別し、トークン化します。次に、トークンとそれに対応する2次元座標をGCNに送り込み、グラフの構築とメッセージの受け渡しを行います。次に、提案する RichAtt メカニズムを用いた拡張トランスフォーマー構造(ETC:Extended Transformer Construction)レイヤーを用いて、スキーマ学習(すなわち意味的実体の抽出)のためにGCNエンコードされた構造を考慮したトークンの処理を継続的に行う。最後に、事後確率を最大化する順序を求めるビタビアルゴリズム(Viterbi algorithm)を用いて復号し、最終的な実体を得て出力します。

拡張トランスフォーマー構造(ETC)

FormNetモデルのバックボーンとしてETCを採用します。ETCは二次的な複雑さを持つ標準的なAttentionを、グローバル入力トークンとロング入力トークンを区別する疎なglobal-local Attentionメカニズムに置き換えることにより、比較的長い入力に拡張します。

グローバルトークンは全てのトークンに注目し、またそれらによって注目されますが、ロングトークンは指定された半径内にある他のロングトークンにのみ局所的に注目し、長いシーケンスに対してより管理しやすいように複雑さを軽減しています。

Rich Attention(RichAtt)

私達の新しいアーキテクチャであるRichAttは、embeddingsを完全に避けることにより、絶対embeddingsと相対embeddingsが持つ欠点を回避しています。その代わりに、レイアウトグリッド上のx軸とy軸に対するトークンのペアの順序と対数距離を計算し、その値の直接関数として各ペアのpre-softmax attentionスコアを調整します。

従来のAttention層では、各トークンの特徴表現は、Queryベクトル、Keyベクトル、およびValueベクトルに線形変換されます。トークンは情報を吸収したい(すなわち注意を払いたい)他のKeyベクトルを持つトークンを「探し」ます。

Keyベクトルは、Queryベクトルと行列乗算(Matmul:matrix-multiplied)し、ソフトマックス正規化したときに比較的高いスコアを生成するものです。

次にトークンは文中の他のすべてのトークンのValueベクトルを合計し、そのスコアで重み付けし、これをネットワークに渡しますが、通常はトークンの元の入力ベクトルに追加されます。

3.FormNet:書式に基づいた文書理解を実現(1/2)関連リンク

1)ai.googleblog.com

FormNet: Beyond Sequential Modeling for Form-Based Document Understanding

2)arxiv.org

FormNet: Structural Encoding beyond Sequential Modeling in Form Document Information Extraction